freiesMagazin Dezember 2016

(ISSN 1867-7991)Themen dieser Ausgabe sind u. a.

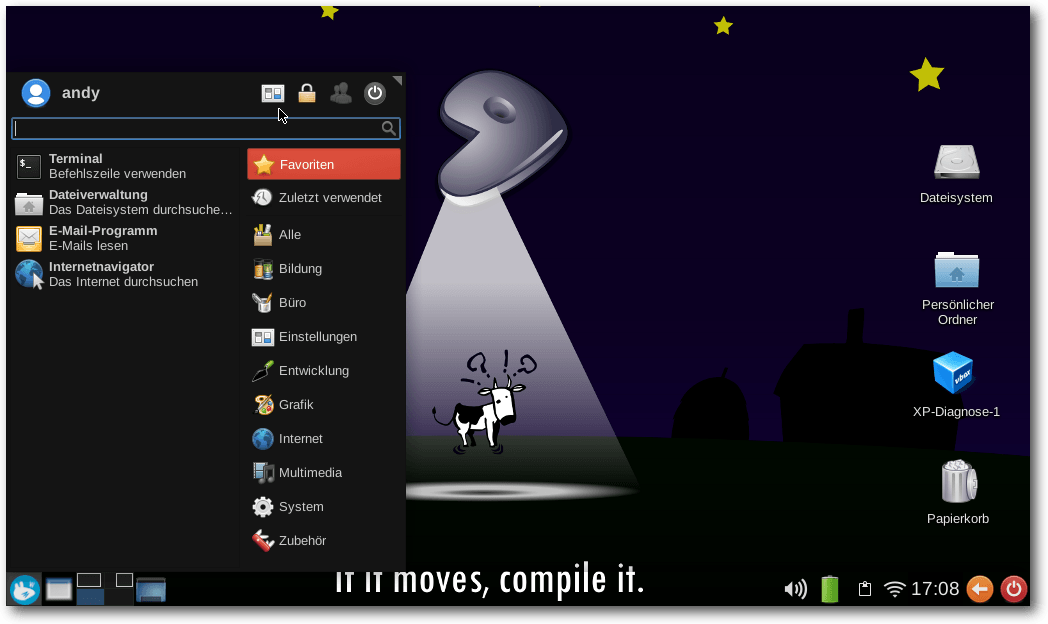

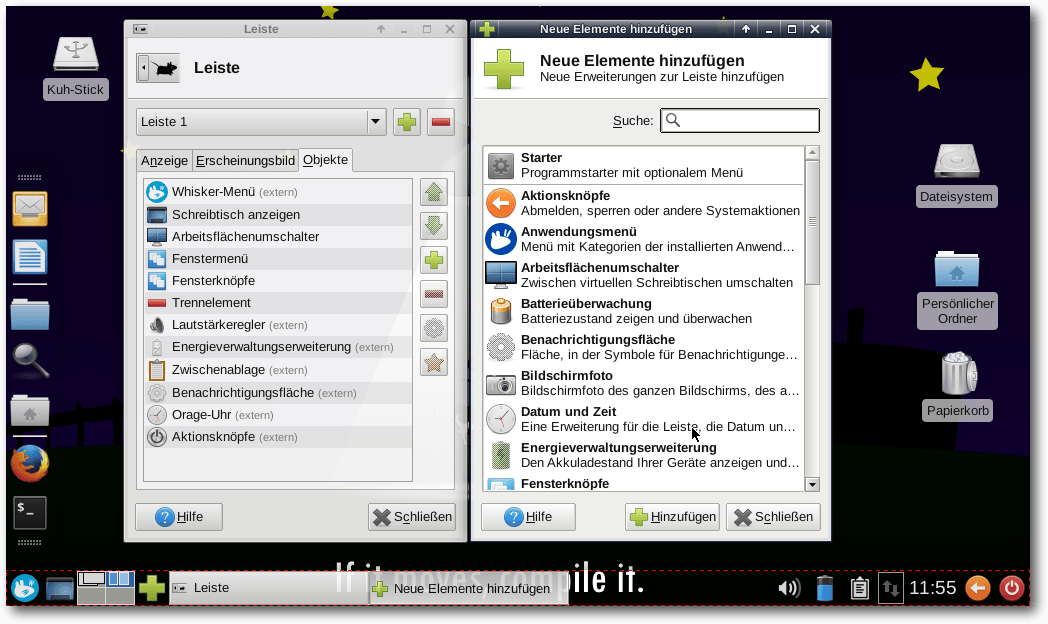

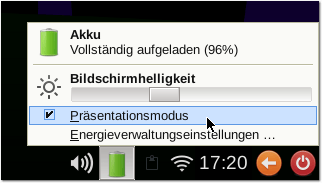

Jenkins ist eine vielgenutzte Software, welche im Zusammenhang mit kontinuierlicher Integration von Software zur Automatisierung eingesetzt wird. Jenkins wurde im Frühjahr 2016 in der Version 2.0 freigegeben, wodurch sich der Fokus vom reinen CI-Server zum generellen Automation Server änderte. (weiterlesen)Der Xfce-Desktop gilt landläufig als minimalistischer und Ressourcen-schonender Vertreter seiner Gattung. Vermutlich kommt er deshalb meist optisch und funktional eher wenig ansprechend vorkonfiguriert daher, um dessen Einsatzfähigkeit auch noch auf besonders schwachbrüstigen Hardwareplattformen zu gewährleisten. Das soll aber nicht darüber hinweg täuschen, dass dieser Desktop durch sein modulares Baukastensystem Stück für Stück in Aussehen und Funktionalität erweitert werden kann. So lässt er sich sehr flexibel an nahezu sämtliche Wünsche und Anforderungen des Nutzers anpassen. Wie das in der Praxis funktioniert, soll dieser Artikel beispielhaft veranschaulichen. (weiterlesen)

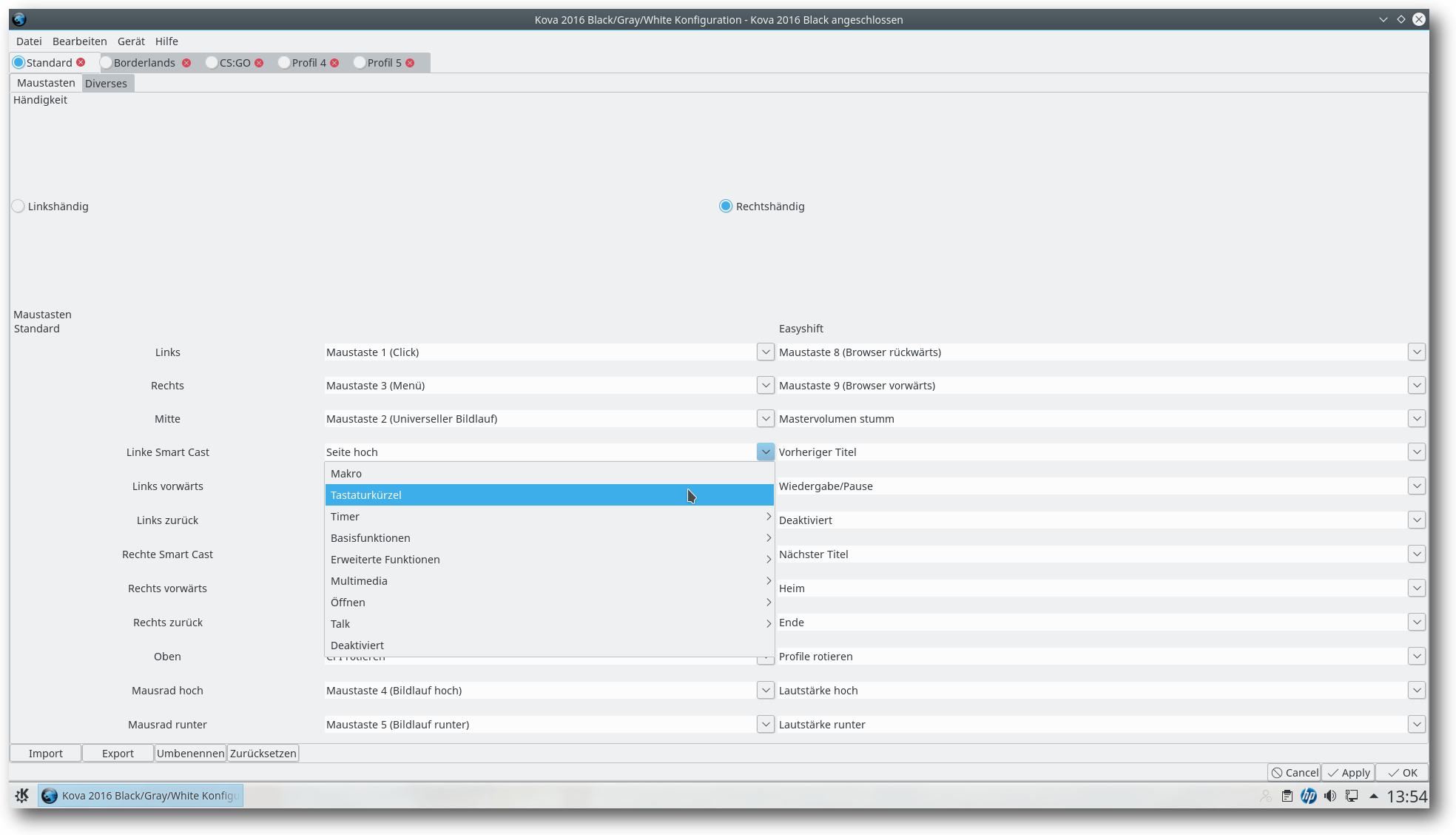

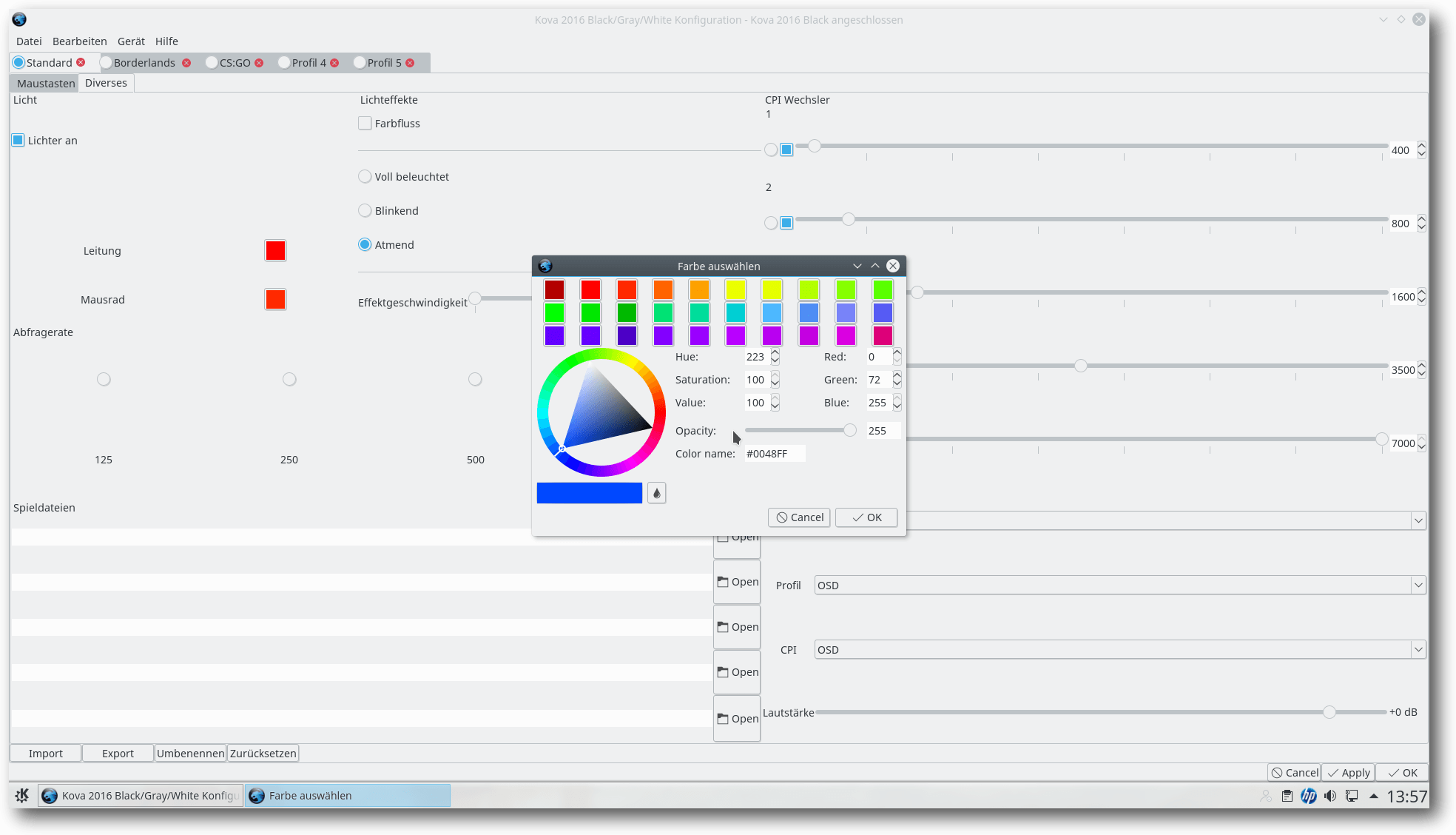

Spezielle Gaming-Hardware wie Tastaturen und Mäuse gibt es reichlich. In Sachen Linux-Kompatibilität sieht es in diesem Bereich leider relativ schlecht aus. Die Roccat Kova 2016 hat eine Besonderheit: Es gibt auch unter Linux ein Tool zur Steuerung aller Sondertasten. Ist die Maus also eine Überlegung Wert für den Linux-Gamer? (weiterlesen)

Zum Inhaltsverzeichnis

Inhalt

Linux allgemeinUbuntu und Kubuntu 16.10

Automatisierung mit Jenkins 2.0

openSUSE Leap 42.2

Freie Software im Bereich Android

Diashow beim Booten mit Plymouth

Der November im letzten Kernelrückblick

Anleitungen

Xfce-Desktop individuell anpassen

Ansible und WSGI-Applikationen

Scribus in der Praxis – Teil 2

Skripten mit Emacs

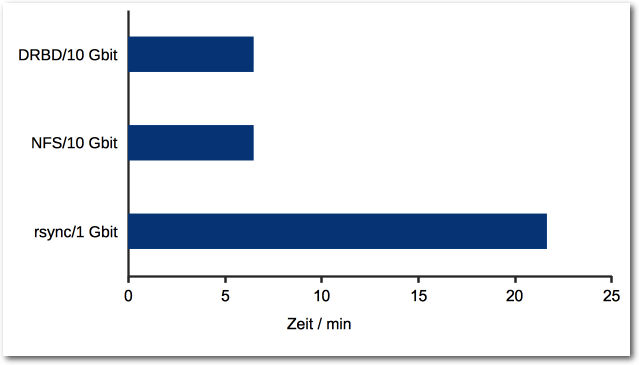

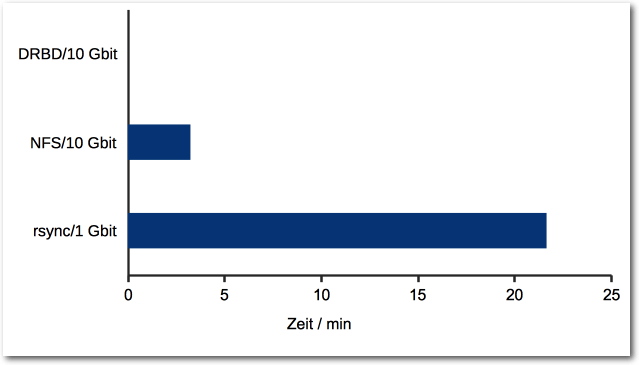

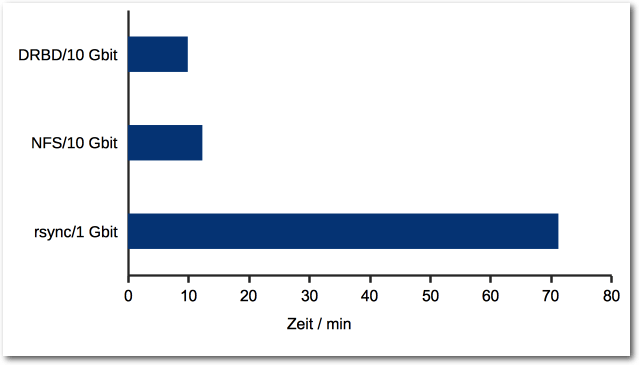

Große Dateien übers Netzwerk kopieren

Software

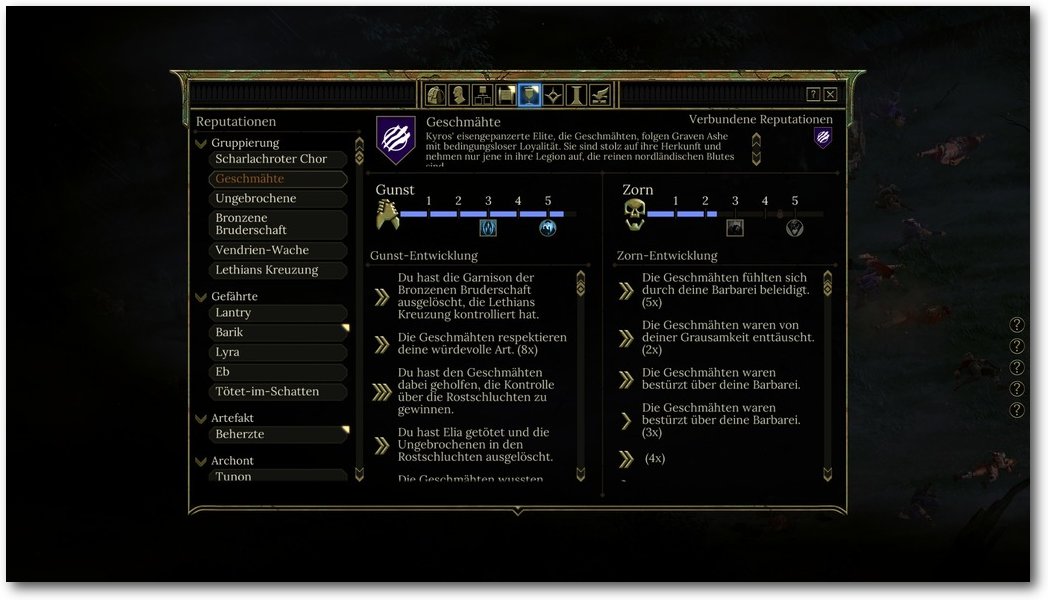

Test: Tyranny

Test: Master of Orion

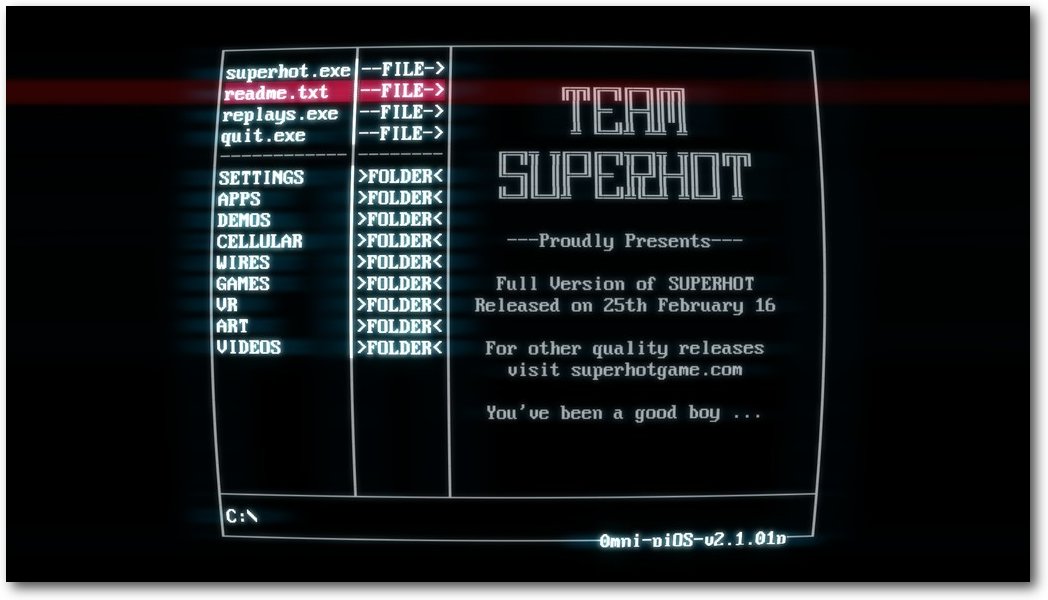

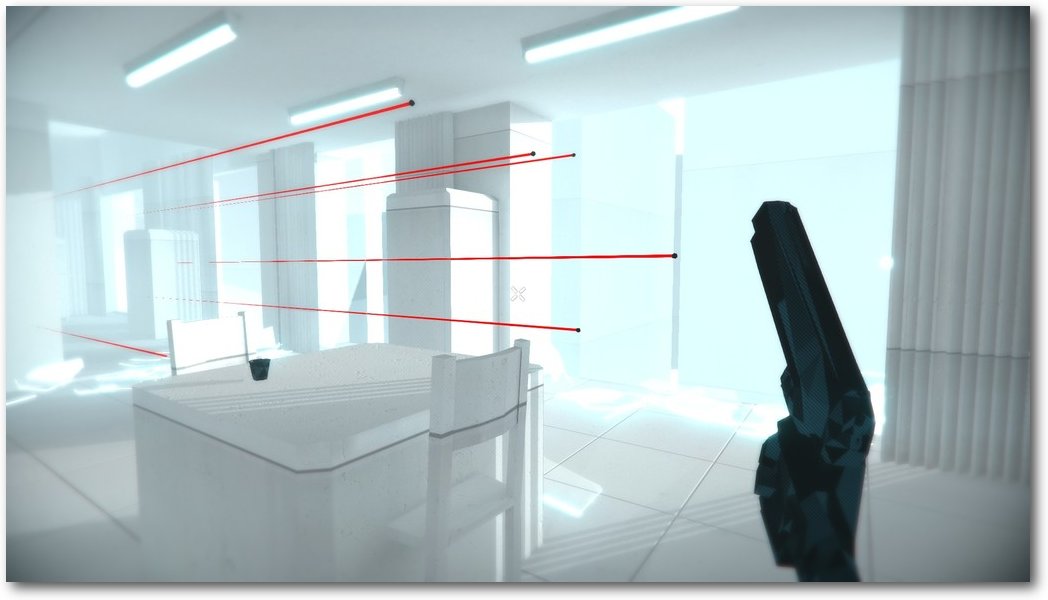

Test: Superhot

Hardware

Gaming-Maus im Test: Roccat Kova 2016

Community

Rezension: NODE.js

Rezension: Ubuntu 16.04

Magazin

Editorial

Leserbriefe

Veranstaltungen

Konventionen

freiesMagazin-Index 2016

Impressum

Zum Inhaltsverzeichnis

Editorial

Macht's gut, und danke für den Fisch

Mit einem Zitat von Douglas Adams [1] kann man sich eigentlich nie falsch verabschieden, oder? Nun ist schlussendlich soweit: Die letzte Ausgabe von freiesMagazin liegt in Ihren Händen bzw. ist auf Ihrem Monitor, Tablet oder Smartphone zu sehen. Ein bisschen schwermütig ist mir (Dominik Wagenführ) ja schon ums Herz. Vor allem, wenn man das Inhaltsverzeichnis betrachtet und die Seitenzahl sieht … 95 Seiten! Wow! So eine riesige Zahl haben wir nicht einmal annähernd in den letzten zehn Jahren hinbekommen. Okay, ein bisschen haben wir mit den Leserbriefen und dem Index geschummelt. Und okay, einige Artikel erschienen bereits auf anderen Portalen. Dennoch wollen wir die Leistung nicht schmälern, die in dieser riesigen, letzten freiesMagazin-Ausgabe steckt. Dies zeigt auch wieder sehr schön, was eine Community erreichen kann – wenn jemand da ist, der das Ruder in die Hand nimmt und ein bisschen die Richtung vorgibt. Auch wenn es in den letzten Jahren so aussah, dass die Mithilfe – nicht nur bei freiesMagazin, sondern auch bei anderen Open-Source-Projekten – geringer geworden ist, finden sich da draußen immer noch zahlreiche begeisterte Nutzer, die etwas zurückgeben wollen. All denen kann ich nur sagen: Macht weiter so! Und allen anderen: Versucht es doch auch einmal! :)Ich bin ein Autor und habe meine Heimat verloren

Wenn Sie zu dem Community-Teil gehören, der gerne selbst etwas gestaltet und für den freiesMagazin eine gern gesehene Plattform war, um eigene Inhalte zu veröffentlichen, dann können wir auf ein paar Alternativen verweisen. Pro-Linux [2] ist den meisten Lesern sicherlich ein Begriff. Hans-Joachim Baader, Mirko Lindner und einige andere Helfer veröffentlichten jeden Tag fleißig News und schreiben regelmäßig Artikel zu den großen Linux-Distributionen. Es werden aber auch immer wieder unterstützende Kräfte von außen gesucht, die etwas beisteuern wollen. Daher einfach einmal anfragen. Ein bisschen spezifischer geht es bei Games4Linux [3] zu. Das Team um David Schroff schreibt begeistert Spielenachrichten und Testartikel zu den neuesten Titeln, die man unter Linux zocken kann. Auch wenn es im Vergleich zu Windows immer noch ein kleiner Bruchteil ist, ist die Auswahl an Spielen im Vergleich zu den Anfangstagen von freiesMagazin um ein Vielfaches gestiegen. Auch hier können wir andere Linux-Spieler nur ermuntern, etwas auf dem Portal beizutragen. Am Schluss sei natürlich noch der Ursprung von freiesMagazin erwähnt. 2006 als loser Newsletter aus dem Nachrichtenportal der deutschsprachigen Ubuntu-Community ubuntuusers.de, Ikhaya [4], entstanden, entwickelte sich freiesMagazin rasant zu der Form, die heute vor Ihnen liegt. Ab und an werden auch noch Artikel in Ikhaya veröffentlicht. Im Fokus ist natürlich Ubuntu, aber auch Blicke über den Tellerrand hat das Ikhaya-Team nie gescheut. Unter Umständen entsteht daraus ja wieder ein neues Projekt, wenn sich genügend Freiwillige und Treiber finden.Gesichert bis zum Ende aller Tage

Es gingen bei den Leserbriefen – neben den zahlreichen Danksagungen – auch einige Fragen ein, was mit den bisherigen Ausgaben von freiesMagazin geschieht. Wie im letzten Editorial geschrieben, haben wir uns hier noch nicht genau entschieden. Im Prinzip wollen wir die gesamte Webseite in einer statischen Form erhalten, sodass man auch weiterhin an Kommentare, die Programmierwettbewerbe und andere Inhalte kommt. Das Ganze soll möglichst so umgesetzt werden, dass es keine toten Links gibt. Wir schauen, inwieweit uns das gelingt … Für die Archivierung sei zuerst auf die Deutsche Nationalbibliothek hingewiesen, in der man alle Ausgaben von freiesMagazin seit Ausgabe 07/2010 findet [5]. Frühere Ausgaben haben wir dort nicht archiviert, da wir damals noch keine ISSN besaßen. Ansonsten waren aber auch unsere Leser nicht untätig und haben sicherheitshalber schon einmal alle Ausgaben archiviert. Beispielsweise hat Urs Pfister auf der Seite http://archivista.ch/freiesmagazinde-archiv.htm [6] ein durchsuchbares Archiv erstellt. Achtung: Der Link „PDF“ funktioniert aktuell nicht! Ein weiteres Archiv hat Dieter R. Gülden erstellt. Unter https://www.dguelden.de/magazine/archiv.html [7] findet man eine übersichtliche Tabelle mit den PDF-Ausgaben. Zusätzlich gibt es auf der rechten Seite auch noch einen Index und er hat die Ausgaben noch nach eigenen Kategorien eingeordnet. Und auch bei GitHub ist freiesMagazin dank Sascha Mester nun vertreten. Unter https://github.com/SaschaMester/freiesMagazin [8] findet man alle Ausgaben als PDF und EPUB. Auch die Archive sind enthalten sowie die alten Ausgaben von Yalm (Yet another linux magazine), die auf dem freiesMagazin-Server gehostet wurden [9]. Wer den Aboservice von Leser Christoph nutzen wollte, den wir im letzten Editorial vorgestellt haben, hatte natürlich nur maximal diese Dezember-Ausgabe etwas davon. Christoph wies uns darauf hin, dass die Adressdaten nach dem Versand der letzten Ausgabe gelöscht werden. Zusätzlich ist sein Projekt ebenfalls auf GitHub zu finden [10], falls jemand einen Blick in den Quellcode werfen möchte. Zum Schluss sei noch auf ein Projekt von Josua Kiefner hingewiesen, der auch in dieser Ausgabe mit einem Artikel zum Thema „Freie Software im Bereich Android“ vertreten ist. Er hat ein Skript allHTML.sh geschrieben, welches alle HTML-Ausgaben von freiesMagazin herunterlädt, ordnet und die CSS-Darstellung für Mobilgeräte verbessert. Ein Indexer durchsucht die Artikel dann nach Schlagworten, wobei die Suche dank JavaScript ohne Webserver auskommt. Lizenziert ist das Skript allHTML.sh unter der GNU GPLv3. Leider hat er die Daten noch nicht auf einem eigenem Server bzw. einer Code-Hosting-Seite hochgeladen. Wer aber Interesse an dem Skript hat, kann sich bei uns melden, wir leiten dies dann an Josua weiter.So lügt man mit Statistik

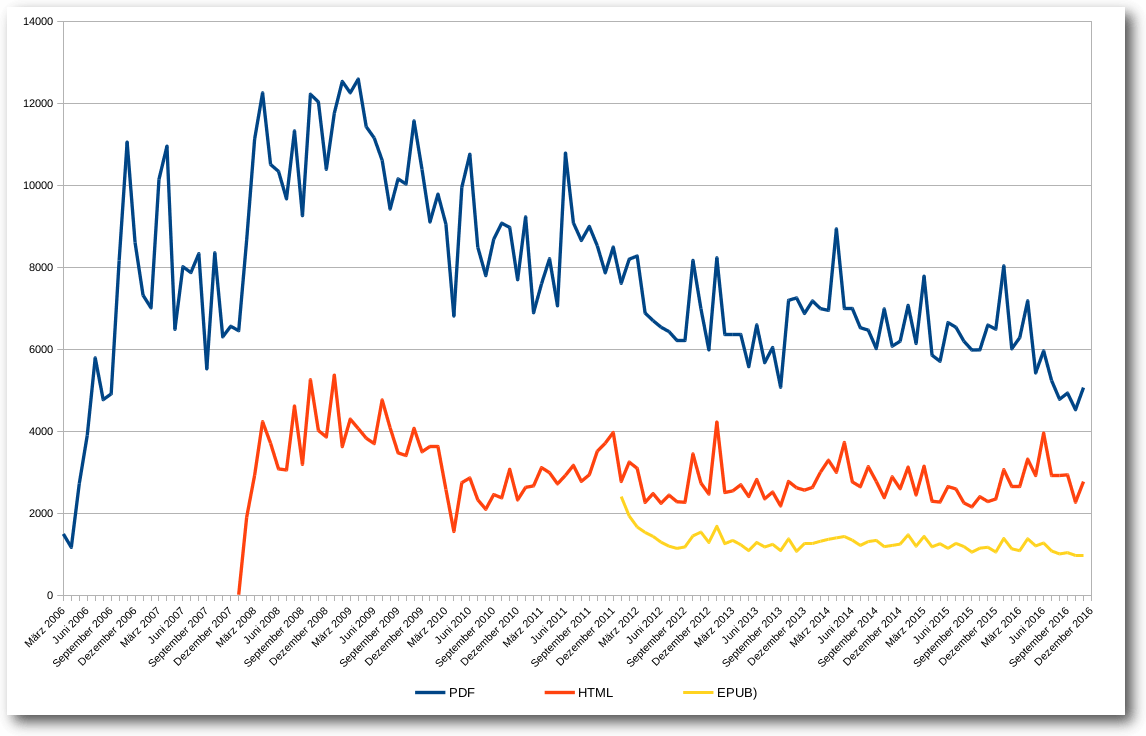

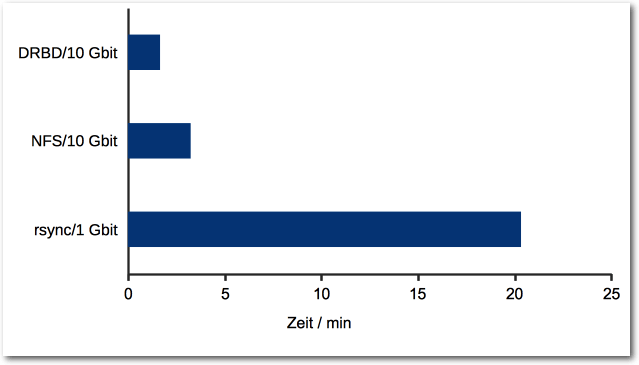

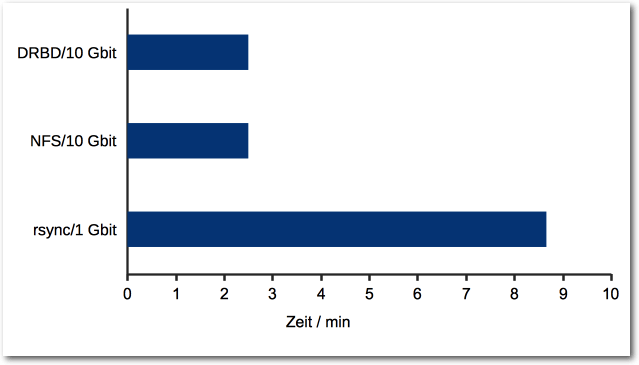

Seitens der Leser gab es auch die Frage, ob man zum Abschluss nicht einige Statistiken zum freiesMagazin präsentieren kann. Wir haben aus dem Grund einmal unser Archiv und die Logdateien durchforstet und sind auf einige interessante Dinge gestoßen. Für viele am Interessantesten ist sicherlich die globale Downloadstatistik der Jahre 2006 bis 2016. Hierzu sei vorab gesagt, dass es nicht ganz so einfach ist, Downloads korrekt zu zählen: Manchmal bricht ein Download ab und wird erneut begonnen. Vor allem bei HTML-Seiten ist es insgesamt schwer, irgendeinen verlässlichen Wert abzulesen. Wir haben deswegen die Zahlen auch nur als Indikator für das allgemeine Interesse am Magazin gesehen. Die Zahlen in der Grafik geben dabei immer nur die Downloads im Erscheinungsmonat an.

freiesMagazin-Downloads.

Die Grafik zeigt sehr schön, wie freiesMagazin vor allem in den Jahren 2008 und 2009 eine echte Hochzeit erlebt hat. Ab 2011 ging der Trend dann leider immer weiter abwärts. Es gab zwar immer noch einzelne Spitzen, aber wir konnten keine weiteren Leser gewinnen. Da man bei Community-Projekten sehr oft von einer 90-9-1-Regel spricht (d. h. 90% sind passiv, 9% beteiligen sich gelegentlich aktiv und 1% ist der harte, aktive Kern [11]) zeigt dies eben auch, dass bei nachlassendem Leser-Interesse auch die daraus resultierenden Autoren weniger werden. freiesMagazin war eben immer ein Projekt, welches von der Community für die Community gestaltet wurde. Im Hintergrund werkelten eben nur ein „paar“ Menschen, die dem Ganzen eine Form nach außen verschafften, die berühmten 1% – zu denen aber auch einige Autoren gehören, die viele Jahre lang immer wieder etwas zu freiesMagazin beigetragen haben (siehe unten). Wenn man einmal die Summe über alle Downloads (ohne Dezember 2016), natürlich über die letzten zehn Jahre, rechnet, kommen beachtliche Zahlen zustande (jeweils nur für die Erstdownloads im Erscheinungsmonat): 996.469 PDF-Downloads seit März 2016 (d. h. wir knacken mit der Dezember-Ausgabe die Millionenmarke, wohoo! :)), 318.258 HTML-Ansichten seit Januar 2008 und 75.952 EPUB-Downloads seit Januar 2012. Die Zahlen können sich also sehen lassen. Natürlich haben wir mit den Downloads nicht eine Millionen Menschen erreicht – zumindest nicht direkt über unsere Seite. Die Hoffnung ist ja immer, dass das Magazin auch separat weitergegeben und verteilt wurde, um ein Interesse für Linux und Open Source zu wecken. Wieso aber so viele Downloads? Sprich, was wurde denn überhaupt heruntergeladen? Die Gesamtzahl aller PDF-Seiten für die 130 Ausgaben (diesmal inklusive der aktuellen Dezemberausgabe) ist 5571. Damit kann man der Dunkler-Turm-Reihe von Stephen King noch nicht ganz das Wasser reichen, aber man hätte schon eine Weile zu tun, dies alles am Stück zu lesen. Von der Seitenzahl muss man natürlich wiederkehrende Dinge wie das Impressum oder die Titelseite abziehen, dennoch bleibt eine Zahl über der 5000 stehen. Auf diesen über 5000 Seiten wurden insgesamt 1177 Artikel und 78 News (ja, in den Anfängen des Magazins gab es noch regelmäßig Nachrichten zu lesen) abgedruckt. Verfasst wurden diese Artikel von ca. 200 Autoren. Warum nur circa? Hier hat unsere Datenbank einen kleinen „Fehler“ und zählt „Vorname Nachname“ und „Nachname, Vorname“ als zwei unterschiedliche Einträge. Das hatte uns bisher nie gestört … Na ja, bis heute eben. Nichtsdestotrotz ist selbst eine Zahl unter 200 immer noch eine erstaunliche Anzahl an Autoren. Die Top-3-Schreiber sind dann auch leicht gefunden: Mit 226 Artikeln führt Dominik Wagenführ (Schreiber dieser Zeilen und Chefredakteur von freiesMagazin) das Feld an, gefolgt von Kernelschreiber Mathias Menzer mit 108 Artikeln, wiederum gefolgt von Jochen Schnelle mit 72 Artikeln, den man zurecht als Bücherwurm bezeichnen kann, da von den 72 Artikeln 53 Buchrezensionen waren. Natürlich soll die Leistung aller anderen Autoren nicht geschmälert werden! Jeder Artikel hat freiesMagazin ein Gesicht gegeben und zu dem gemacht, was es heute ist. Bedanken möchte ich mich abschließend zum einen noch einmal beim freiesMagazin-Team und allen Helfern, die Monat für Monat dazu beigetragen haben, dass das Magazin erstellt wurde. Es waren sehr viele Hände, durch die das Magazin gegangen ist. Ich kenne die genaue Anzahl nicht, schätzungsweise waren aber sicherlich um die 50-60 Personen im Laufe der Jahre im freiesMagazin-Team tätig. Ein besonderer Dank geht dabei an die ursprünglichen Initiatoren bzw. Gestalter des Magazins in den Anfangstagen, darunter vor allem Eva Drud und Marcus Fischer, die ich damals vor ca. neun Jahren beerbt habe. Und mit diesem längsten Editorial in der zehnjährigen Geschichte des Magazins verabschiedet sich die freiesMagazin-Redaktion von Ihnen und wünscht allen Lesern ein schönes Weihnachtsfest, ein gutes Jahr 2017 und insgesamt die besten Wünsche für die Zukunft. Links

[1] https://de.wikipedia.org/wiki/Douglas_Adams

[2] http://www.pro-linux.de/

[3] http://games4linux.de/

[4] https://ikhaya.ubuntuusers.de/

[5] http://d-nb.info/1004344759

[6] http://archivista.ch/freiesmagazinde-archiv.htm

[7] https://www.dguelden.de/magazine/archiv.html

[8] https://github.com/SaschaMester/freiesMagazin

[9] http://www.freiesmagazin.de/yalm

[10] https://github.com/monochromec/fm

[11] https://www.nngroup.com/articles/participation-inequality/

Beitrag teilen Beitrag kommentieren

Zum Inhaltsverzeichnis

Ubuntu und Kubuntu 16.10

von Hans-Joachim Baader Dieser Artikel beleuchtet die Neuerungen von Ubuntu 16.10 „Yakkety Yak“ vor allem in den beiden wichtigsten Desktop-Ausgaben, Unity und KDE. Die neueste Version der Ubuntu-Distribution wurde wie geplant am 13. Oktober 2016 veröffentlicht und wird für neun Monate unterstützt. Ob das reicht oder ob man eine LTS-Version nutzen sollte, zeigt der Artikel. Redaktioneller Hinweis: Der Artikel „Ubuntu und Kubuntu 16.10“ erschien erstmals bei Pro-Linux [1].Generelles

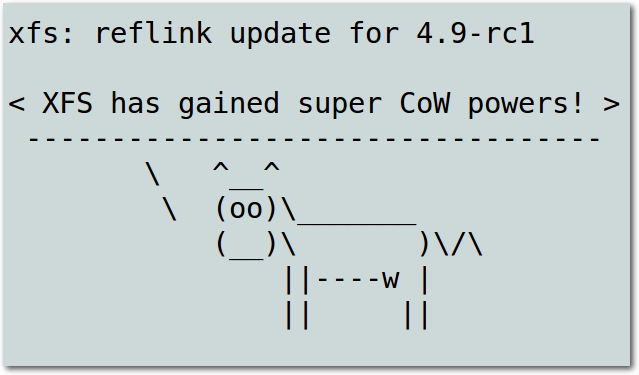

Wie nicht anders zu erwarten, wurde Ubuntu 16.10 „Yakkety Yak“ genau zum vorgesehenen Termin am 13. Oktober veröffentlicht. Ubuntu und alle seine Varianten erhalten ab der Veröffentlichung neun Monate lang Unterstützung. Wer eine längere Unterstützung wünscht, sollte Ubuntu 16.04 LTS einsetzen (siehe freiesMagazin 07/2016 [2]). Der Schwerpunkt des Artikels liegt zwar auf den Desktopumgebungen Unity und KDE, aber auch die Änderungen in den anderen Ubuntu-Varianten sollen kurz aufgeführt werden. Außerdem soll auch die Software, die allen Varianten gemeinsam ist, in diesem Abschnitt zur Sprache kommen. Das meiste davon kann nur kurz beschrieben werden, da es sich einem eingehenden Test entzieht. Ubuntu 16.10 [3] verwendet den Linux-Kernel 4.8, der keinen leichten Start hatte: Trotz oder gerade wegen einer Verzögerung der Freigabe um eine Woche hatte sich Debug-Code eingeschlichen [4], der bei einigen Benutzern ziemlich schnell zu einer Kernel-Panik und damit zum Stillstand des Systems führte. Nur kurz darauf musste noch einmal gepatcht werden, um den Dirty COW-Fehler zu beseitigen [5]. Immerhin kann man bei Ubuntu sicher sein, dass diese Updates schnell zu den Benutzern gelangen. Trotz alledem bringt Linux 4.8 zahlreiche Verbesserungen und Neuerungen mit sich und sollte den älteren Kerneln in Sachen Funktionalität, Geschwindigkeit und Energieeffizienz überlegen sein. Das Dateisystem ZFS wird weiter als Binärmodul mitgeliefert. Auch wenn sich ein halbes Jahr lang in der Diskussion darüber nichts getan hat, gilt das für viele immer noch als GPL-Verletzung (siehe Stallmans Aussage [6]). Auf der Anwendungsseite wurde GnuPG auf Version 2.1.15 aktualisiert, LibreOffice auf Version 5.2. Zusätzlich wurde LibreOffice auf eine GTK+ 3-Oberfläche umgestellt. Der Update-Manager zeigt nun Änderungslog-Einträge auch für PPAs an. Die GNOME-Apps wurden auf GNOME 3.20, teils auch GNOME 3.22 aktualisiert. Der GNOME-Dateimanager Nautilus wurde auf Version 3.20 gebracht. Systemd ist in Version 231 dabei und übernimmt jetzt nach den Systemsitzungen auch die Verwaltung der Benutzersitzungen. Auf der Server-Seite wird vor allem die erst eine Woche zuvor erschienene OpenStack-Version „Newton“ hervorgehoben. Über das Repository „Ubuntu CloudArchive“ [7] können auch die Benutzer der LTS-Versionen 12.04, 14.04 und 16.04 auf OpenStack „Newton“ aufrüsten. Weitere Aktualisierungen sind qemu 2.6.1, DPDK 16.07, libvirt 2.1, Open vSwitch 2.6, LXD 2.4.1, Docker 1.12.1, MAAS 2.0, Juju 2.0 und cloud-init. Die Neuerungen von cloud-init wurden auch in Ubuntu 16.04 LTS eingebaut. Die Unterstützung für IBM LinuxONE und zSystem wurde deutlich erweitert. So sind jetzt die neuen s390-tools 1.36.1 vorhanden, die Pakete numactl und zfcpdump wurden hinzugefügt und in OpenSSL wurde die Hardware-Beschleunigung aktiviert. Ubuntu Server ist aber auch für andere Power-Prozessoren sowie ARMv8-A erhältlich. Ubuntu Server ist stark auf Container ausgerichtet. Neben Docker und LXD sieht Canonical auch das neue Paketformat Snap, das neben dem DEB-Format existieren kann, als Container, speziell als sogenannte Anwendungscontainer. Nach der Einführung in Ubuntu 16.04 LTS wird jetzt die aktualisierte Version 2.16 mitgeliefert, die auch auf Ubuntu 16.04 LTS und 14.04 LTS sowie auf einigen anderen Linux-Systemen verfügbar ist. Ubuntu Kylin [8], die Ubuntu-Version für den chinesischen Markt, erhielt ein aktualisiertes Design und andere Updates. Weitere Varianten von Ubuntu werden nicht von Canonical, sondern von der Gemeinschaft gepflegt. Kubuntu [9] enthält Plasma 5.7 und die KDE Frameworks 5.26 sowie die Anwendungen des KDE-Projekts in Version 16.04.3. Lubuntu [10], die Variante mit LXDE, wollte offenbar mit der aktuellen Version auf LXQt umstellen, was jedoch um ein halbes Jahr verschoben wurde. Außer einer Aktualisierung des grafischen Designs gab es daher in Lubuntu diesmal keine spezifischen Änderungen. Ubuntu GNOME [11] bietet den Ubuntu-Anwendern jetzt GNOME 3.20. Viele Anwendungen wurden aber gleich auf den Stand von GNOME 3.22 gebracht. Einige der Neuerungen sind die signifikant verbesserte Suchfunktion im Dateimanager Nautilus, Anzeigen von interessanten Orten in Maps, eine MPRIS-kompatible Mediensteuerung im Dropdown-Kalender, nichtdestruktives Editieren von Bildern in Fotos und Hochladen zu Google, eine Anzeige der jeweils möglichen Tastenkombinationen und Multitouch-Gesten („Shortcuts“) in vielen Anwendungen. Das Programm „Initial Setup“ wurde erstmals eingebunden und wird beim ersten Hochfahren gestartet. Zudem bietet Ubuntu GNOME eine voll funktionsfähige Wayland-Sitzung zum Testen an. Von Xubuntu [12], der Variante mit Xfce-Desktop, gibt es kaum sichtbare Änderungen zu vermelden. Das Team arbeitet daran, Xfce von GTK+ 2 auf GTK+ 3 zu portieren. Während die Distribution nach wie vor auf GTK+ 2 beruht, sind auf GTK+ 3 portierte Anwendungen und Plug-ins zum Testen bereits erhältlich. Für Ubuntu Mate [13] ist Version 16.10 ein Meilenstein: Die Weiterentwicklung der GNOME-2-Desktopumgebung wurde auf GTK+ 3 portiert, wobei GTK+ ebenso wie Mate selbst mehrfach aktualisiert wurden. Enthalten sind jetzt Mate 1.16 und GTK+ 3.20. Dank der Unterstützung durch die Gemeinschaft über eine Crowdfunding-Kampagne konnte die Portierung auf GTK+ 3 ein halbes Jahr früher als vorgesehen abgeschlossen werden. Beim eher auf Stabilität bedachten Ubuntu Studio [14], das sich an Kreative und Künstler aller Art richtet, wurden dgedit, drumgizmo, gpick, Calibre, pdf-shuffler und plume-creator hinzugefügt, gnome-color-manager durch dispcalgui ersetzt und Krita vorübergehend ganz entfernt. Ferner wurde recordmydesktop durch vokoscreen ersetzt. Im Lieferumfang befinden sich unter anderem Ardour 5.0.0, Blender 2.77a, Darktable 2.0.5, Font Manager 0.7.2, Gimp 2.8.18, Inkscape 0.91, KDEnlive 16.04.3, LMMS 1.1.3, Pitivi 0.97.1, qJackCtl 0.4.2 und Scribus 1.4.6.Installation

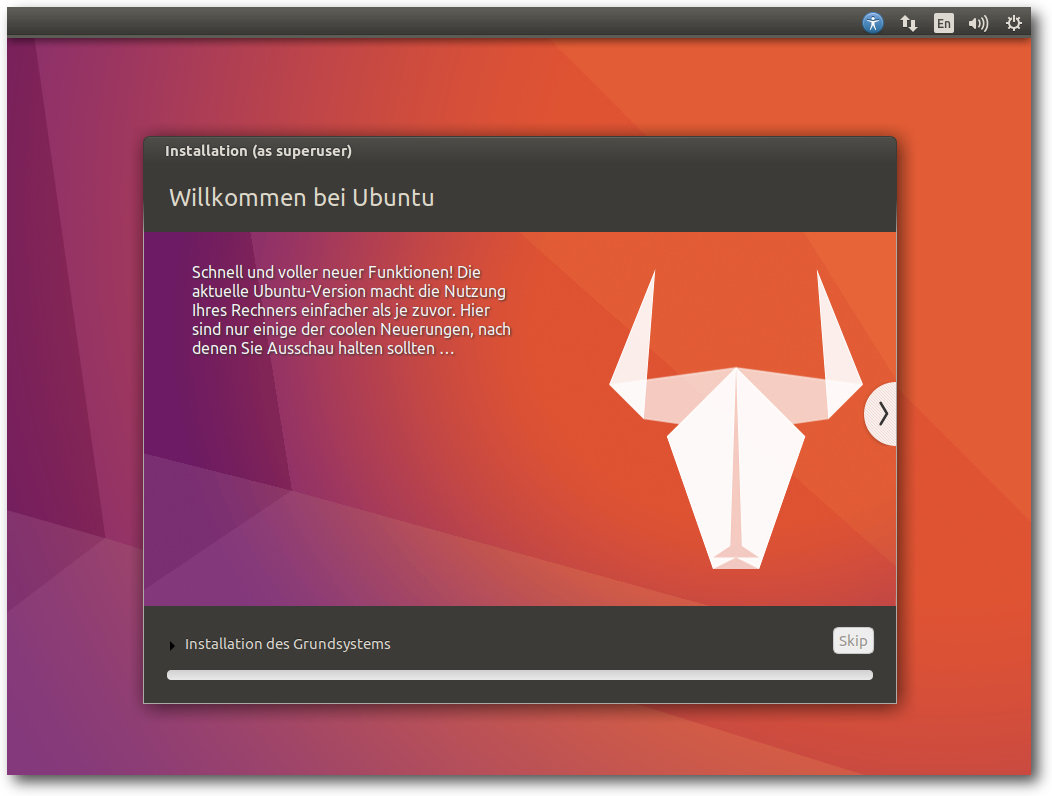

Die Installation von Ubuntu ist wie immer kein Problem, denn sie geht schneller und einfacher vonstatten als bei den meisten anderen Distributionen. Für Testzwecke ist extrem schnell ein lauffähiges System installiert, weil man hier größtenteils die Standardeinstellungen verwenden kann. Für ein dauerhaft eingesetztes System lohnt es sich allerdings, mehr Aufwand zu betreiben und von den erweiterten Optionen Gebrauch zu machen, die weitgehend alle nur denkbaren Bedürfnisse abdecken. Die einfachste Installation bietet ein Live-System, das als ISO-Image zum Download bereitsteht. Dieses „Desktop-Image“ ist rund 1,6 GB groß und kann auf DVD oder einem USB-Medium verwendet werden. Gegenüber der Vorversion ist es nochmals um knapp 0,1 GB gewachsen. Das ISO der Kubuntu-Variante ist mit etwas über 1,5 GB fast gleich groß geblieben. Gegenüber der Vorversion hat sich an der Installation nichts Merkliches geändert, nur das Design wurde wieder einmal etwas angepasst. Das Installationsprogramm Ubiquity bietet ähnlich wie der Debian-Installer oder Anaconda von Fedora alle Möglichkeiten an, die Festplatten zu partitionieren und das System darauf zu installieren. Die gesamte Festplatte oder einzelne Partitionen können verschlüsselt werden, und LVM wird unterstützt, wenn man die automatische Partitionierung auswählt. Merkwürdigerweise fehlt LVM, wenn man manuell partitionieren will. Auch ZFS wird zum Installationszeitpunkt noch nicht unterstützt. Das gilt auch, wenn man die Installation im Expertenmodus startet, was nur über eine Option des Bootloaders möglich ist. Unklar ist dabei aber, ob der Expertenmodus überhaupt noch eine Auswirkung hat. Nachdem die Partitionierung definiert ist, beginnt im Hintergrund bereits die Installation, die in weniger als einer halben Stunde beendet ist. Währenddessen wird man nach weiteren Parametern gefragt. Mit Zeitzone, Tastaturbelegung, Name und Passwort ist dieser Part auch schon abgeschlossen, weitere Angaben werden nicht benötigt.

Fortschritt der Installation.

Allgemeines zum System

Ubuntu startet ziemlich schnell, wie schon in Version 16.04. Es setzt, anders als Kubuntu, eine Hardware-3-D-Beschleunigung voraus, die bei Grafikkarten, die das nicht bieten, durch llvmpipe emuliert wird. Bei einer ausreichend schnellen CPU ist das Verfahren von der Geschwindigkeit immer noch gerade so erträglich, bei zwei oder mehr CPUs ist es mittlerweile ganz brauchbar, von sehr grafikintensiven Anwendungen abgesehen. Das Grafiksystem ist bei X.org 7.7 geblieben, da es keine neue Version von X.org in der Zwischenzeit gab. Allerdings wurden einige Komponenten von X.org aktualisiert, darunter der X-Server 1.18.4, und Mesa 12.0.3. Unity 8 ist als Vorschau mit dabei. Auch mit den neuen Display-Servern Mir und Wayland kann man experimentieren, da entsprechende Sitzungen mit Mir und Unity 8 bzw. Wayland und KDE zur Auswahl stehen. Ansonsten bringt Ubuntu 16.10 auf dem Desktop in erster Linie Korrekturen. Viele Anwendungen erhielten mehr oder weniger große Verbesserungen durch neue Versionen. LibreOffice wird in Version 5.2.2 mitgeliefert. Chromium 53 und Firefox 49 sind unter den mitgelieferten Webbrowsern zu finden. Wie gewohnt hat Root keinen direkten Zugang zum System, sondern die Benutzer der Gruppe sudo können über das Kommando sudo Befehle als Root ausführen. Der Speicherverbrauch von Unity ist gegenüber der Vorversion wieder gestiegen, was aber auch an der aufgebohrten virtuellen Maschine oder anderen Faktoren liegen könnte. Rund 680 MB benötigt die Umgebung allein, ohne dass irgendwelche produktive Software gestartet wurde. Über 240 MB davon entfallen auf Compiz. KDE benötigt in der Standardinstallation mit einem geöffneten Terminal-Fenster etwa 390 MB und damit deutlich weniger als zuvor. Grund dafür ist, dass die KDE-PIM-Suite und Akonadi nicht mehr automatisch, sondern erst bei Bedarf gestartet werden. Die Messung des Speicherverbrauchs der Desktops kann jeweils nur ungefähre Werte ermitteln, die zudem in Abhängigkeit von der Hardware und anderen Faktoren schwanken. Aber als Anhaltspunkt sollten sie allemal genügen.

Ubuntu 16.10.

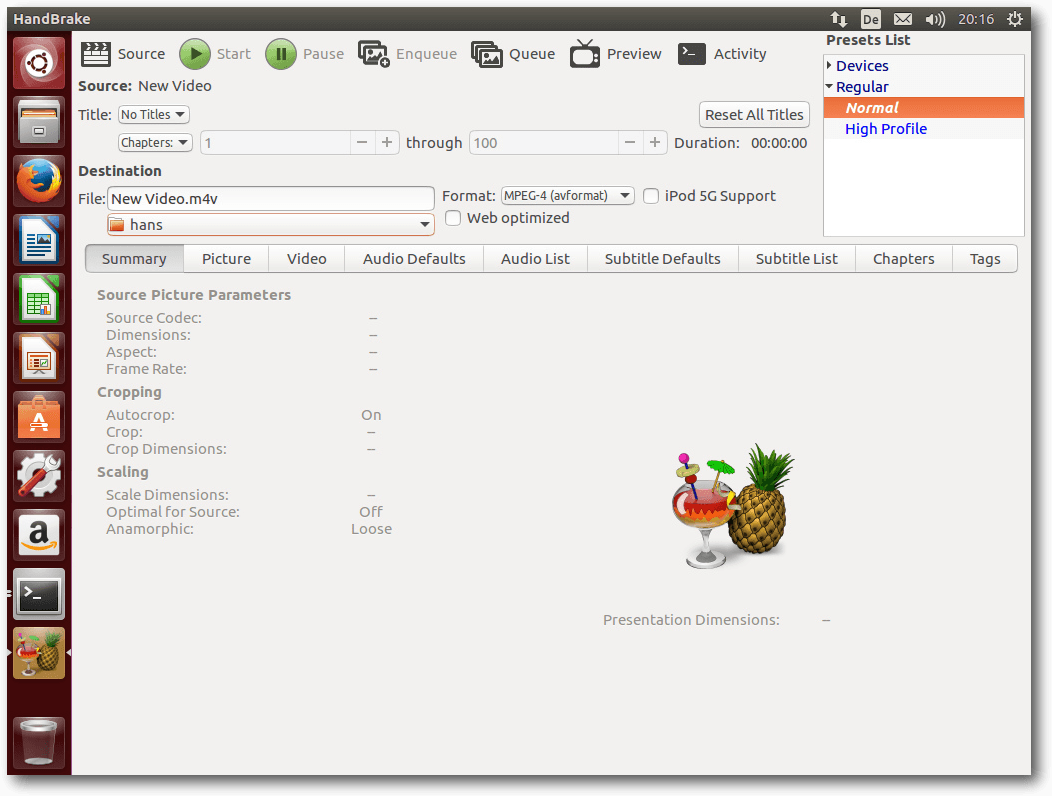

Snap

Snap [15], das neue Paketformat, das Anwendungen in distributionsunabhängige Anwendungscontainer packt, hat inzwischen einen Reifegrad erreicht, der es möglich macht, fast alle Arten von Software zu paketieren. Der Aufwand für solche Pakete hält sich in Grenzen. Bis auf eine YAML-Datei, die das Paket und seine Erzeugung beschreibt, gibt es keine Vorschriften, was ein Snap-Paket zu enthalten hat. Daher ist der Aufwand für die Paketerstellung überschaubar und in der Regel geringer als bei DEB-Paketen. Umfangreiche Dokumentation und Beispiele findet man auf Snapcraft.io [16], in der FAQ [17] und im Github-Repository [18]. Snap-Pakete werden von Root installiert und stehen dann allen Benutzern zur Verfügung. Sie enthalten Anwendungen mitsamt dem größten Teil ihrer Abhängigkeiten, was ihre Aktualisierung unabhängig vom Rest des Systems ermöglicht. Um zu verhindern, dass jedes Snap-Paket eine große Menge duplizierten Codes (Bibliotheken usw.) mitbringt, gibt es Abhängigkeiten zwischen den Paketen (die automatisch aufgelöst werden), und auf der untersten Ebene gibt es definierte Laufzeitumgebungen, z. B. das 75 MB große Snap-Paket ubuntu-core 16.04.1. Jedes Snap-Paket ist versioniert und kann aktualisiert werden. Eine Aktualisierung kann durch ein Zurücksetzen auf eine frühere Version rückgängig gemacht werden. Ein einmal erstelltes Snap-Paket sollte auf allen Systemen laufen, die Snap unterstützen. Anwendungen sind so weit wie möglich voneinander isoliert. Sie sind außerdem vor Änderungen geschützt – technisch ist das so realisiert, dass die Snap-Pakete per Loopback in ein Unterverzeichnis von /snap gemountet werden. Es gibt auch Verzeichnisse, in denen die Snap-Pakete Dateien ablegen dürfen, Konfigurationsdateien ebenso wie andere Daten. Da Snaps fast immer mit anderen Anwendungen oder dem System kommunizieren müssen, gibt es eine laufend erweiterte Liste von Schnittstellen, die solche Verbindungen schaffen. Snap-Pakete müssen deklarieren, welche Schnittstellen sie benötigen oder anbieten, und das System lässt nur die deklarierten Zugriffe zu. Damit kann die Sicherheit des Systems garantiert werden, außer bei X11-Anwendungen. Der Grund ist der, dass X11 nicht darauf ausgelegt ist, Anwendungen voneinander zu isolieren, es bietet einfach nicht die Möglichkeiten dafür. Mit Wayland oder Mir wird das voraussichtlich ganz anders aussehen. Insgesamt erinnert Snap also schon stark an das App-Ökosystem von Android, das sicherlich in vielerlei Hinsicht Ideengeber war. Werden Snaps installiert, dann steigt der Speicherbedarf aufgrund der verwendeten Loopback-Mounts weiter an. Diesen Punkt sollte Canonical noch optimieren, denn dass Programme, die gar nicht gestartet sind, bereits RAM belegen, darf nicht sein. Der Automounter könnte vielleicht Abhilfe schaffen. Mittlerweile gibt es nach Angaben von Canonical über 500 Snap-Pakete. Wie Canonical auf diese Zahl kommt, ist etwas schleierhaft. Aus den Suchen mit snap find lässt sich schließen, dass nur gut 100 Pakete verfügbar sind. Trotzdem ist Snap augenscheinlich schon sehr weit entwickelt. Auch wenn die Entwicklung noch nicht abgeschlossen ist, ist es viel weiter als das ähnlich ausgerichtete Flatpak [19]. Es ist bedauerlich, dass es wieder einmal zwei oder mehr Formate gibt, die miteinander konkurrieren. Snap wird von vielen als Alleingang von Canonical gesehen, ist aber nicht auf Ubuntu beschränkt – Debian hat es (momentan nur in Sid), Gentoo, openSUSE, Arch und sogar Fedora sind mit dabei. Flatpak könnte genauso als Alleingang von Red Hat gesehen werden. Allerdings wurde es inzwischen in GNOME integriert. Wie es weitergeht, bleibt abzuwarten.

Handbrake als Snap-Paket.

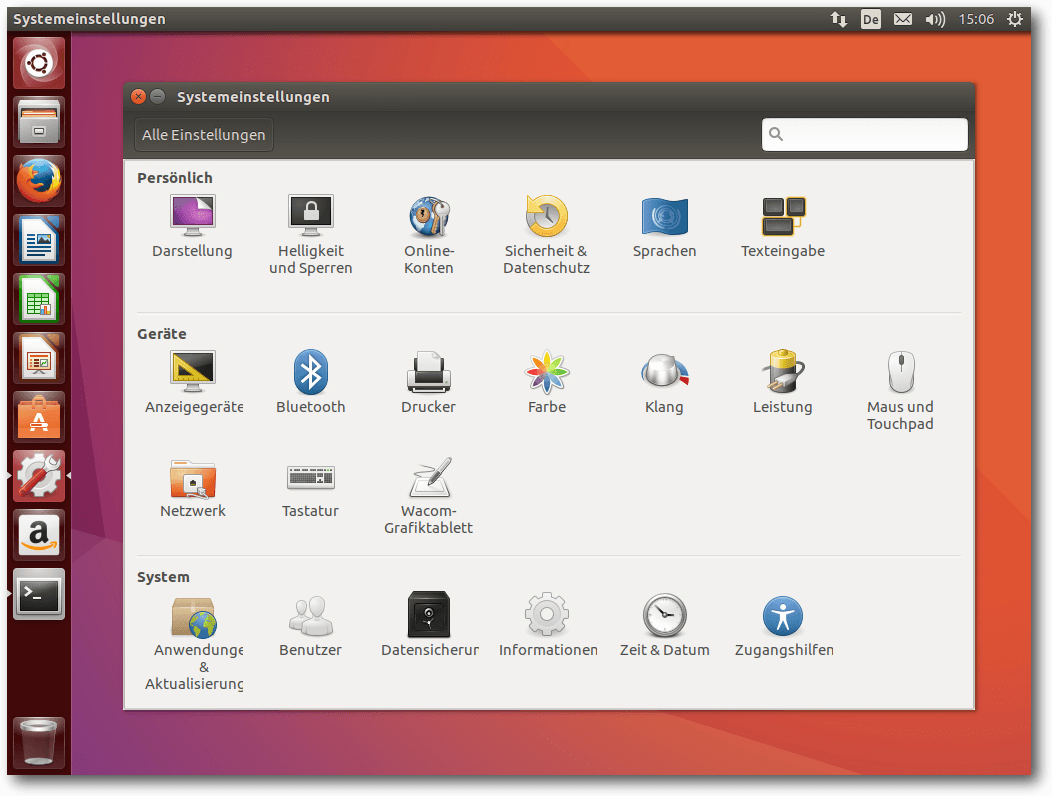

Unity

Unity liegt jetzt in Version 7.5 vor. Die Änderungen gegenüber Version 7.4 bestehen offenbar nur aus Korrekturen und kleinen Verbesserungen, die keine Auswirkungen auf das generelle Verhalten haben. Der Standard-Webbrowser in Ubuntu ist Firefox, die Standard-Büro-Suite LibreOffice. Für E-Mails ist Thunderbird 45.4, dessen Icon nicht in die Startleiste eingebunden ist, zuständig. Die sonstigen installierten Programme sind im Wesentlichen die Standard-Programme von GNOME, die zumindest grundlegend die häufigsten Aufgaben abdecken. In den meisten Fällen bieten sie gerade einmal Grundfunktionen, sodass man sich gerne nach leistungsfähigeren Programmen im Software-Center umsieht. Das Software-Center ist jetzt auf Version 3.20.1 und ist bis auf den Namen weiterhin identisch mit dem GNOME Software-Center. Ubuntus Plan für das Software Center war ursprünglich, Plug-ins zu entwickeln, um die eigenen zusätzlichen Bedürfnisse abzudecken. Zu sehen ist davon immer noch nichts.

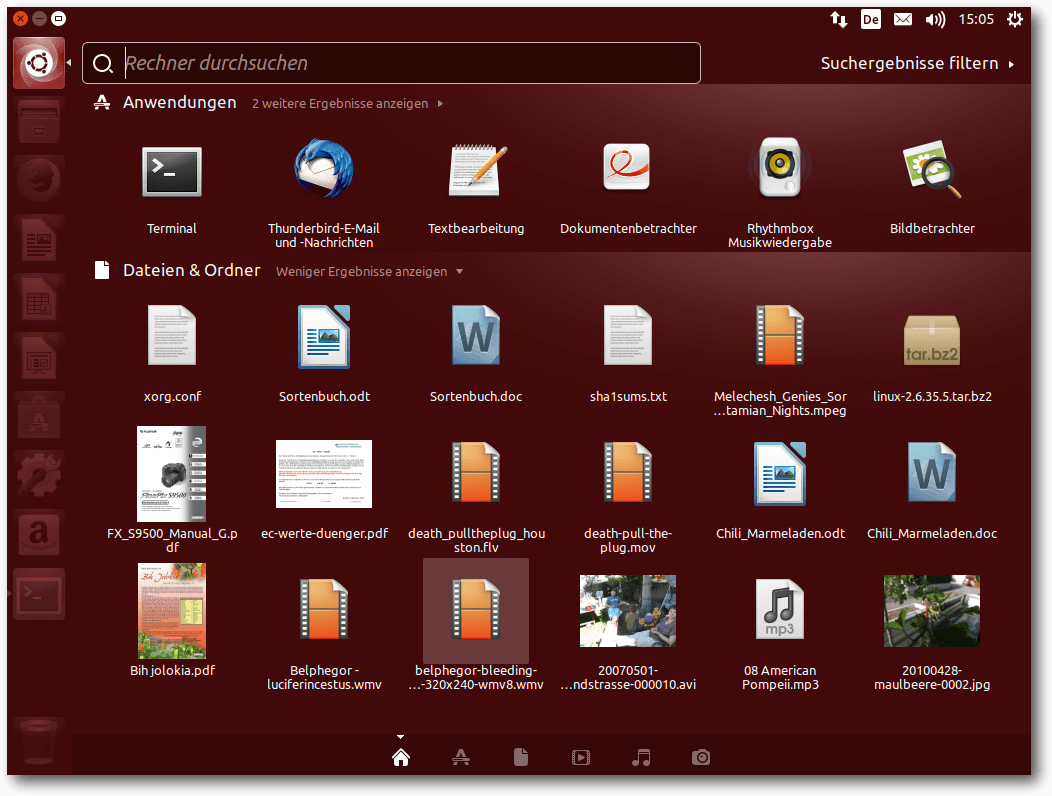

Übersichtsseite von Unity.

Ansonsten gibt es keine Änderungen an Unity, die besonders auffällig sind. Der Schwerpunkt der Entwicklung lag wohl vor allem auf Unity 8, welches jetzt als Vorschau zur Verfügung steht. Was man da sieht, gibt aber noch keinen Anlass zur Freude. Der Display-Server Mir verschwendet CPU-Zyklen ohne Ende und hält die CPU-Last (in der Virtuellen Maschine) ständig über fünf Prozent. Der Mauszeiger erscheint doppelt. Um ein Terminal zu öffnen, muss man umständlich sein Passwort eingeben. Es klemmt an allen Ecken und Enden, weiter soll hier aber gar nicht auf Unity 8 eingegangen werden. Der Speicherbedarf von Unity 8 liegt bei etwa 560 MB, also einiges weniger als Unity 7.5.

KDE

Kubuntu 16.10 setzt den Plasma-Desktop 5.7.5 und die KDE-Anwendungen in Version 16.04.1 ein. Bei den Anwendungen gab es keine allzu großen Änderungen. In Plasma 5.7 erhielten weitere Anwendungen sowie der Anwendungsstarter KRunner die „Jump List Actions“-Funktionalität. Sie ermöglicht es, statt in unübersichtlichen Menüs zu suchen, einige Buchstaben einzutippen, die die gesuchte Funktionalität eingrenzen. Die Anwendung zeigt dann passende Aktionen an. In Plasma 5.7 kehrte die Terminlistenansicht zum Kalender zurück. Das Lautstärken-Applet kann jetzt die Lautstärke für jede Anwendung separat verwalten und die Ausgabe per Drag and Drop auf verschiedene Geräte umleiten. Außerdem kann die Lautstärke auf über 100% angehoben werden. Breeze-Icons in Anwendungen werden nun entsprechend dem gewählten Farbschema eingefärbt, sodass sie besser erkennbar sind. Auch das Kiosk-Framework [20] wurde verbessert und von einigen Fehlern befreit. Die Systemleiste und der Task-Manager wurden noch einmal neu geschrieben, wobei viele frühere Probleme gelöst werden konnten.

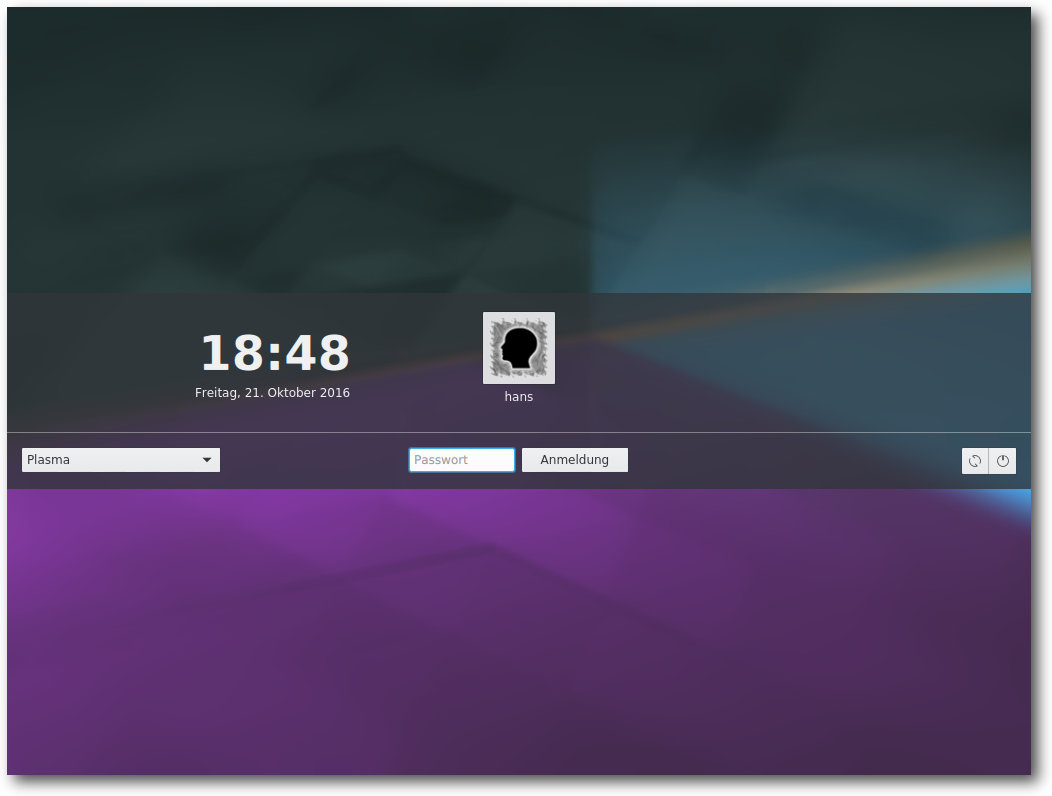

Display-Manager von Kubuntu.

Viele Verbesserungen flossen außerdem in die Zusammenarbeit mit Wayland ein. Kubuntu bietet eine Plasma-Sitzung unter Wayland zum Ausprobieren an, wenn man die benötigten Komponenten installiert. Wayland scheint weniger Speicher zu benötigen als X11 und läuft flüssiger, allerdings wurde im Test der Mauszeiger doppelt angezeigt und folgte der Maus zu träge. Auch sonst gibt es unter Kubuntu noch etliche Probleme: Die Tastatur war auf Englisch eingestellt, konnte aber nachträglich korrekt geändert werden. Der Videoplayer DragonPlayer funktionierte nicht und er stürzte einfach ab. Gleiches ereilte den Videoplayer mpv im Test. Bis zur nächsten Version sollte man von Wayland wohl eher die Finger lassen. Auch Kubuntu installiert Firefox als Standard-Browser, der genauso eingerichtet ist wie unter Unity. Als Musik-Player ist Amarok 2.8 vorinstalliert, wie schon seit Kubuntu 13.10. KDE PIM mit Kontact ist in Version 16.04 installiert. Außerdem ist LibreOffice vorhanden. Weitere Anwendungen muss man aus den Repositories nachinstallieren, wenn man sie braucht. Der Speicherbedarf ist direkt nach dem Start 390 MB, erhöht sich aber, wenn man die KDE-PIM-Suite (z. B. KMail) startet. Das allerdings ist müßig, denn Akonadi ist falsch konfiguriert und kann nicht starten. Damit sind auch KMail, KOrganizer usw. nicht funktionsfähig.

Multimedia im Browser und auf dem Desktop

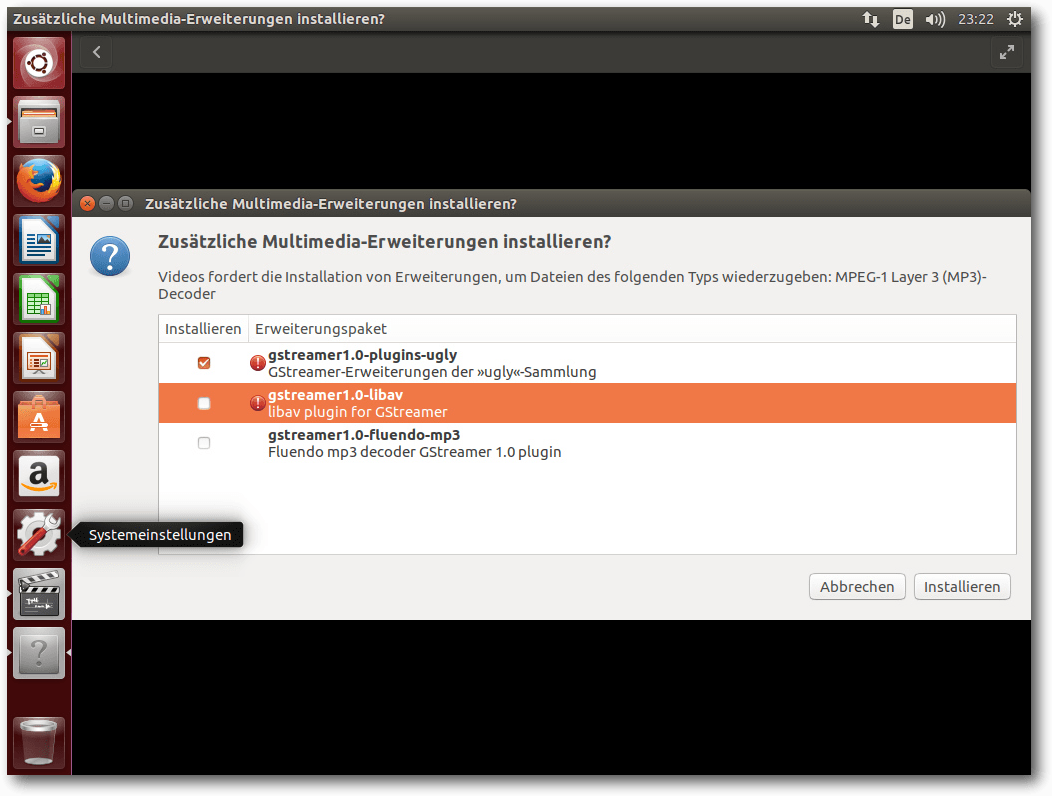

Nicht viel Neues gibt es im Multimedia-Bereich. OpenH264 ist in Firefox als Plug-in vorinstalliert und aktiviert, um WebRTC zu ermöglichen. Der eigentliche Plug-in-Code wird offenbar beim ersten Start heruntergeladen. Diese Vorgehensweise hat ihre Ursache darin, dass Cisco, von dem der Code stammt, nur für das binäre Plug-in die angefallenen Patentlizenzen bezahlt hat. Der Quellcode des Moduls ist unter der BSD-Lizenz verfügbar, allerdings von der Patentlizenz nicht abgedeckt. Die vorinstallierte Firefox-Erweiterung „Ubuntu Firefox Modifications“ ist bei Version 3.2 geblieben. Es ist die einzige vorinstallierte Erweiterung. Wie immer muss man zum Abspielen der meisten Video-Formate (und diverser Audio-Formate wie MP3) zuerst das passende Plug-in installieren. Über die Software-Verwaltung ist das jetzt aber nicht mehr möglich, da alle Bibliotheken daraus verbannt wurden. Viele Anwendungen sind allerdings in der Lage, die Installation selbst anzustoßen. Sie zeigen es in einer Dialogbox an, wenn ein zusätzliches Plug-in benötigt wird. Diese sucht nach passenden GStreamer-Plug-ins, schlägt sie zur Installation vor und kann sie anschließend installieren. Das funktioniert soweit korrekt, nach der Plug-in-Installation muss man allerdings die Player-Software neu starten. Wenn man weiß, was man benötigt, kann man die Plug-ins aber auch von Hand über die Paketverwaltung installieren. Benötigt werden die Pakete gstreamer1.0-libav, gstreamer1.0-plugins-uglyund gstreamer1.0-plugins-bad.GStreamer ist jetzt nur noch in Version 1.8.3 dabei. Von den vorinstallierten Programmen benötigt keines mehr die alte Version 0.10 von GStreamer.

Installation von Multimedia-Erweiterungen.

Das Thema Flash kann man mittlerweile ganz entspannt sehen. Neuentwicklungen mit Flash sind verpönt, und die Zahl der Webseiten, die Flash einsetzen, sinkt. Das heißt aber natürlich nicht, dass alle Flash-Videos jetzt einfach so verschwinden. Es wird sicher noch viele Jahre lang Flash-Videos im Web geben. Da ist es gut, dass Adobe nun auch das NPAPI-Flash-Plugin weiter pflegen will und es auf denselben Stand wie das PPAPI-Plugin bringt. Aktuell ist es als Betaversion verfügbar. Während die proprietären Webbrowser meist einen eingebauten Flash-Player mitbringen, liefert Ubuntu die freien Webbrowser ohne Flash-Plug-in aus. Da aber zum Beispiel Firefox über GStreamer alles abspielen kann, wofür Plug-ins installiert sind, also auch Flash, ist es auch meist nicht nötig. Wenn eine Webseite explizit das Adobe-Flash-Plug-in benötigt, kann man es mit dem Paket flashplugin-installer installieren. Installiert wird dabei die veraltete Version 11.2, die nur noch Fehlerkorrekturen erhält. Die Betaversion wird also noch ignoriert, wer sie aber testen möchte, kann sie problemlos von der Adobe-Seite herunterladen. In Kubuntu ist dieses Mal alles noch konfuser als sonst. Das Standardprogramm zum Ansehen von PDF-Dateien ist LibreOffice Draw. Das ist eine der unsinnigsten Einstellungen, die ich unter Linux je gesehen habe. Im Gegenzug wurde darauf verzichtet, das Programm Okular zu installieren, das normalerweise der PDF-Betrachter von KDE ist. Beim Abspielen von Videos ist unter KDE die Geschwindigkeit auch weiterhin auch ohne 3-D-Hardware akzeptabel. Amarok ist der Standard-Audioplayer, Dragonplayer der Standard-Videoplayer. Früher wurden auch unter Kubuntu fehlende Plug-ins korrekt nachinstalliert oder waren bereits vorhanden. Das ist auch in der neuen Version nicht mehr der Fall. Amarok und Dragonplayer funktionieren schlicht nicht, wenn die Plug-ins fehlen. Leider scheint auch jegliche Unterstützung für die Nachinstallation zu fehlen. Es bleibt nur die Installation von Hand, wie oben bereits beschrieben.

Fazit

In Ubuntu 16.10 gibt es einiges zu experimentieren, darunter Unity 8 mit Mir und KDE mit Wayland. Ersteres ist dabei experimenteller als letzteres. Nicht mehr ganz so experimentell zeigt sich Snap, das zwar noch nicht fertig ist, aber inzwischen fast alle Voraussetzungen erfüllt, zu einem neuen distributionsübergreifenden Standard zu werden. Die fortgesetzten Arbeiten an Unity 8, Mir und Snap sind wohl auch die Erklärung dafür, dass es ansonsten in Ubuntu 16.10 wenig Änderungen zu vermelden gibt. Nachdem Kubuntu keine offizielle Unterstützung von Canonical mehr genießt, scheint das Projekt mit einigen Schwierigkeiten zu kämpfen zu haben. Zwar wurde die Aktualisierung auf KDE Plasma 5.7 geschafft, das sich zunehmend gereift zeigt und auch unter Wayland kurz vor einer guten Benutzbarkeit steht. Testen hingegen scheint man bei Kubuntu für altmodisch oder überflüssig zu halten. Anders ist nicht zu erklären, dass Akonadi und damit alle Anwendungen der KDE-PIM-Suite funktionsunfähig sind, oder dass man LibreOffice Draw als PDF-Betrachter erhält. Alles in allem ist Ubuntu 16.10 vielversprechend, es gilt aber wie immer: Wer Ubuntu produktiv nutzen will, sollte eine der LTS-Versionen verwenden. Wer experimentieren oder nahe an den aktuellen Entwicklungsständen daran sein will, kann dagegen Ubuntu 16.10 nutzen. Links[1] http://www.pro-linux.de/artikel/2/1853/ubuntu-und-kubuntu-1610.html

[2] http://www.freiesmagazin.de/freiesMagazin-2016-07

[3] https://wiki.ubuntu.com/YakketyYak/ReleaseNotes

[4] http://www.pro-linux.de/news/1/24045/torvalds-verärgert-über-fehler-im-kernel-48.html

[5] http://www.pro-linux.de/news/1/24096/sicherheitslücke-im-linux-kernel-ermöglicht-lokale-rechteausweitung.html

[6] http://www.pro-linux.de/news/1/23452/stallman-zfs-und-linux-unvereinbar.html

[7] https://wiki.ubuntu.com/OpenStack/CloudArchive

[8] https://wiki.ubuntu.com/YakketyYak/ReleaseNotes/UbuntuKylin

[9] https://wiki.ubuntu.com/YakketyYak/ReleaseNotes/Kubuntu

[10] https://wiki.ubuntu.com/YakketyYak/ReleaseNotes/Lubuntu

[11] https://wiki.ubuntu.com/YakketyYak/ReleaseNotes/UbuntuGNOME

[12] https://xubuntu.org/news/xubuntu-16-10-release

[13] https://ubuntu-mate.org/blog/ubuntu-mate-yakkety-final-release/

[14] https://wiki.ubuntu.com/YakketyYak/ReleaseNotes/UbuntuStudio

[15] https://www.ubuntu.com/desktop/snappy

[16] http://snapcraft.io/

[17] https://developer.ubuntu.com/en/snappy/support/faq/

[18] https://github.com/ubuntu/snappy-playpen

[19] http://flatpak.org/

[20] https://userbase.kde.org/KDE_System_Administration/Kiosk/Introduction

Autoreninformation |

| Hans-Joachim Baader (Webseite) befasst sich bereits seit 1993 mit Linux. 1994 schloss er erfolgreich sein Informatikstudium ab, machte die Softwareentwicklung zum Beruf und ist einer der Betreiber von Pro-Linux.de. |

Beitrag teilen Beitrag kommentieren

Zum Inhaltsverzeichnis

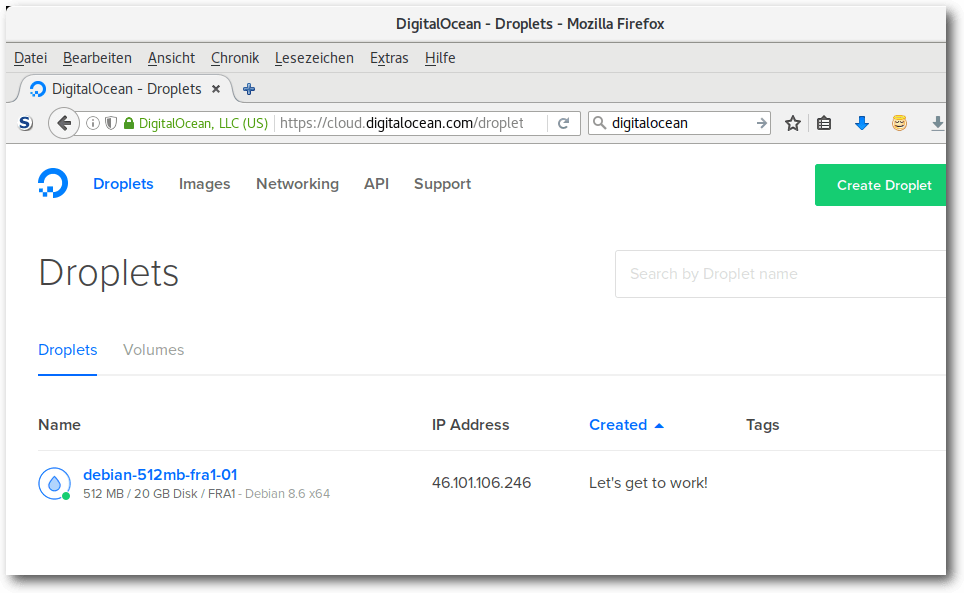

Automatisierung mit Jenkins 2.0

von Sujeevan Vijayakumaran Jenkins [1] ist eine vielgenutzte Software, welche im Zusammenhang mit kontinuierlicher Integration von Software zur Automatisierung eingesetzt wird. Jenkins wurde im Frühjahr 2016 in der Version 2.0 freigegeben, wodurch sich der Fokus vom reinen CI-Server zum generellen Automation Server änderte. In freiesMagazin 01/2013 [2] wurde Jenkins bereits im Bezug zur kontinuierliche Integration behandelt. Der Fokus in diesem Artikel liegt weniger auf dem Thema Kontinuierliche Integration, sondern mehr auf den Neuerungen, die in Version 2.0 Einzug hielten.Jenkins-CI 1.x

Bevor es an die Neuerungen von Jenkins 2.0 geht, erfolgt zuvor noch eine Einführung in die wesentlichen Elemente und Funktionen, die sowohl in Jenkins-CI 1.x als auch in Jenkins 2.0 verfügbar sind. Jenkins ist ein Tool, womit sich viel automatisieren lässt. Es wird am häufigsten im Rahmen der kontinuierlichen Integration genutzt, um regelmäßig das jeweilige Software-Projekt zu bauen, zu testen und ein Release-Paket zu schnüren. Einfach ausgedrückt ist Jenkins eine Oberfläche, womit sich regelmäßige Aktionen verwalten und ausführen lassen. Man könnte fast sagen, dass es eine aufgeblähte Cron-Oberfläche ist, aber das stimmt natürlich so nicht ganz. In Jenkins lassen sich sogenannte Jobs definieren, dessen Hauptbestandteil häufig Shell-Skripte sind. Ein solcher Jenkins-Job teilt sich in sechs Teile auf. Der erste Teil sind die allgemeinen Einstellungen des Jobs, in denen etwa der Name und eine Beschreibung des Jobs spezifiziert werden kann. Der zweite Teil ist das Source-Code-Management. Dort wird angegeben, an welchem Ort der Code des Projektes liegt. Jenkins unterstützt nativ und durch den Einsatz diverser Plug-ins zahlreiche Versionskontrollsysteme wie CVS, Subversion und auch Git. Es lassen sich sowohl die Quelle angeben, als auch mögliche Branches, die ausgecheckt werden sollen. Nachdem man diese beiden Einstellungen getätigt hat, folgt die eigentliche Konfiguration des Builds. Wie zuvor erwähnt, kann man Jenkins auch ein wenig mit Cron vergleichen, da regelmäßig Jobs ausgeführt werden können. Wie und wann die Jobs ausgeführt werden, kann im Build-Auslöser Schritt definiert werden. Eine einfache Möglichkeit ist die Ausführung zu bestimmten Uhrzeiten, diese verwendet sogar die Cron-Syntax. Damit lassen sich etwa Nightly-Builds umsetzen, bei denen die Jenkins-Jobs einmal in der Nacht ausgeführt werden. Alternativ ist es ebenfalls möglich bei jedem neuen Commit das Projekt zu bauen oder im Nachgang eines Vorgänger-Jenkins-Jobs. Der eigentliche Ablauf wird im Buildverfahren abgebildet. Dies sind häufig Shell-Skripte unter Linux- und BSD-Systemen und Batch unter Windows. Durch den Einsatz von Plug-ins lassen sich einige Build-Schritte im Build-Verfahren auch ohne Skripte lösen; das kommt dann jeweils auf die Projekt-Art und Programmiersprache an. Statt Skripte sind dort dann Formularfelder enthalten, die man ausfüllen muss. Im Build-Verfahren wird bei einem Software-Projekt häufig das Projekt zuerst gebaut und anschließend die geschriebenen Tests ausgeführt. Sofern bei beiden Schritten kein fataler Fehler auftritt, sollten die Test-Ergebnisse als XML-Dateien herausgeschrieben werden, die in den Post-Build-Aktionen von Jenkins ausgewertet werden. Das ist somit auch der letzte Schritt, bei dem nicht nur die Test-Auswertung stattfinden kann, sondern die Ergebnisse auch per Jabber, E-Mail oder sonstigem Kommunikationsmittel versandt werden können. Im definierten und ausgeführten Job kann man nach der Ausführung des Jobs den Status sehen. Falls das Projekt erfolgreich gebaut und die Tests fehlerfrei ausgeführt wurden, ist der Status des Jobs „Erfolgreich“, was mit einer blauen Kugel dargestellt wird. Auch gelbe bei instabilen Jobs mit einigen fehlgeschlagenen Tests oder rote Kugeln bei fehlgeschlagenen Jobs sind möglich. Der Job zeigt mehr oder weniger übersichtlich an, welche Tests fehlschlagen sind, seit wann diese Tests fehlschlagen und auch einen übersichtlichen Graphen mit der Anzahl und Ergebnisse der Tests. Jenkins lässt sich vielfältig einsetzen und das nicht nur zur Ausführung von Builds und Tests von Projekten. Die größte Stärke liegt in den zahlreichen Erweiterungsmöglichkeiten mittels Plug-ins. Jenkins-Jobs laufen auf einem Jenkins-Knoten – welche auch häufig Jenkins-Slaves oder Build-Executors genannt werden – und diese können auf allen gängigen Betriebssystemen laufen, da fast nur Java gebraucht wird. Jenkins hat immer zwei aktuelle Versionen: eine LTS-Version und eine normale Version. Die normale Version folgt einem wöchentlichen Rhythmus und ist die „Bleeding Edge“-Version. Diese sollte man nicht im produktiven Einsatz verwenden, da dort häufig noch viele Fehler enthalten sind. Stattdessen sollte man lieber zur LTS-Version greifen, die einen stabilen Stand darstellt und alle drei bis vier Monate auf Basis der Nicht-LTS-Version gebaut wird. Je nachdem, wie intensiv man Jenkins nutzt, passiert es auch schnell, dass viele Funktionen in Plug-ins genutzt werden, die nochmal separat aktualisiert werden müssen. Dafür gibt es auch eine eigene Plug-in-Verwaltung, die installierbare und aktualisierbare Plug-ins auflistet.

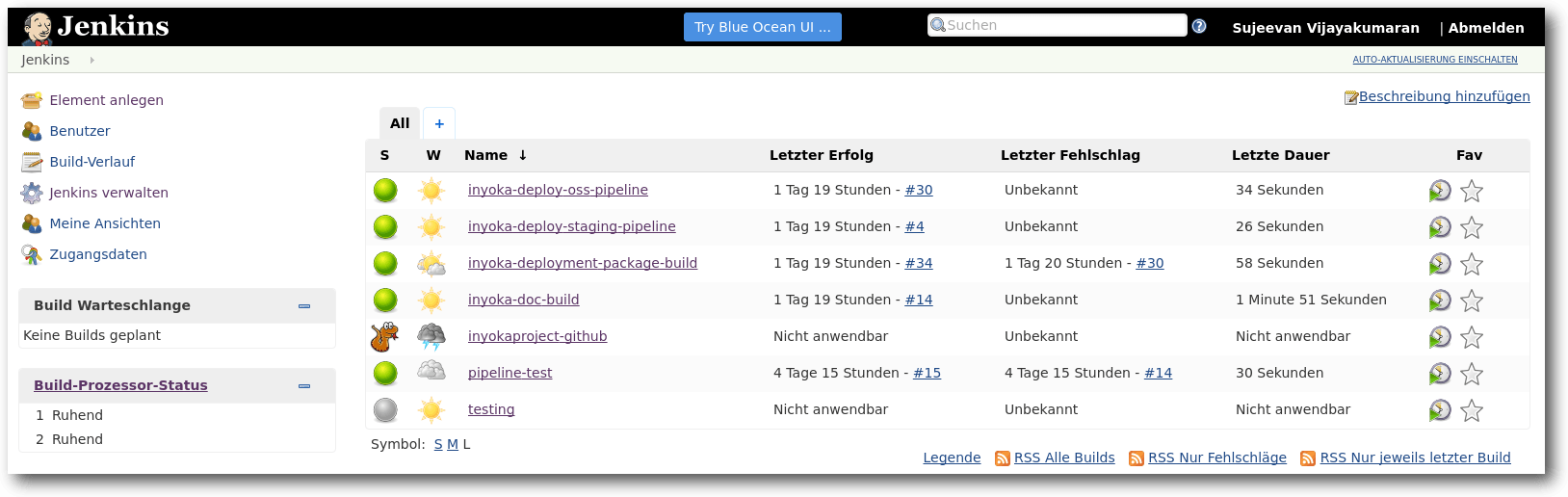

Übersicht über die konfigurierten Jenkins-Jobs.

Jenkins 1.x hatte einige Nachteile, die in Jenkins 2.0 ausgemerzt werden sollten. Ein Punkt war, dass die initiale Konfiguration von Jenkins durchaus zeitaufwendig und wenig intuitiv war. In der Standard-Installation war der Server nämlich komplett offen und frei zugänglich. So konnte jeder ohne irgendeine Authentifizierung Jobs anlegen und auf dem Server laufen lassen. Die Absicherung mit Vergabe von passenden Rechten war für Jenkins-Einsteiger eher schwierig und umständlich, was den Einstieg deutlich erschwerte. Ein weiterer wesentlicher Nachteil von den oben vorgestellten „Free Style“-Jenkins-Jobs ist, dass die Konfiguration der Jobs vollständig auf dem Jenkins-Master gespeichert ist. Die Jobs sind aber in der Regel abhängig von dem Code, der im Source-Code-Management-System hinterlegt ist. Einzelne Teile der Job-Konfiguration ließen sich zwar im Repository speichern und ausführen, aber eben nicht alles und schön war dies auch nicht sonderlich. Das Problem ist insbesondere, dass keine Versionierung erfolgte und man über die Zeit gegebenenfalls keine älteren Stände mittels Jenkins bauen konnte, außer, wenn die alten Jobs gesichert wurden. Das war in der Regel wenig komfortabel und wurde über die Zeit meist unübersichtlich. Außerdem war auch die Konfiguration von Jenkins-Jobs mit steigender Komplexität von Projekten immer aufwendiger. Wenn man etwa in einem Projekt mehrere Branches hatte, bei denen die gleichen Jobs mit einigen Änderungen ausgeführt werden sollten, dann musste der Job mehrfach kopiert werden und bei Änderungen, die jeden Job betrafen, musste jeder Job einzeln angepasst werden. Das machte die Jenkins-Konfiguration weder einfach, noch machte es Spaß. Diese drei Punkte waren die wesentlichen Punkte, die in Jenkins 2.0 verbessert werden sollten.

Jenkins 2.0

Jenkins 2.0 erschien im Frühjahr 2016. Die erste LTS-Version 2.7 erfolgte ein paar Monate später im Sommer. Jenkins wurde vom CI-Server zum reinen Automation Server umgenannt, da Jenkins schon länger nicht mehr nur als reiner CI-Server diente. Auch die URL des Projektes änderte sich von jenkins-ci.org zu jenkins.io [1]. Viele Nachteile und Umständlichkeiten wurden in Jenkins 2.0 verbessert. Das wohl größte Feature ist die Nutzung von sogenannten „Pipelines“, die als Code in einer Datei gespeichert und mit dem restlichen Code des Projektes versioniert werden. Diese Features wurden größtenteils in Plug-ins implementiert, die getrennt vom eigentlichen Jenkins aktualisiert werden. Pipelines sollen nicht nur bei der Continuous Integration unterstützten, sondern auch beim Continuous Delivery, also beim Ausliefern und Ausrollen von Software. Die ursprünglich komplett offene Basis-Installation wurde dadurch abgesichert, dass beim ersten Start von Jenkins sich zuerst ein Einrichtungsassistent öffnet, der nicht nur Basis-Plug-ins zur Installation anbietet, sondern auch einen Nutzer-Account erstellt und die Rechte entsprechend setzt. Weitere nützliche Features sind die Einführung des „GitHub Organization Plugin“ und des „Multibranch-Pipeline“. Aber dazu später mehr.Pipeline as Code

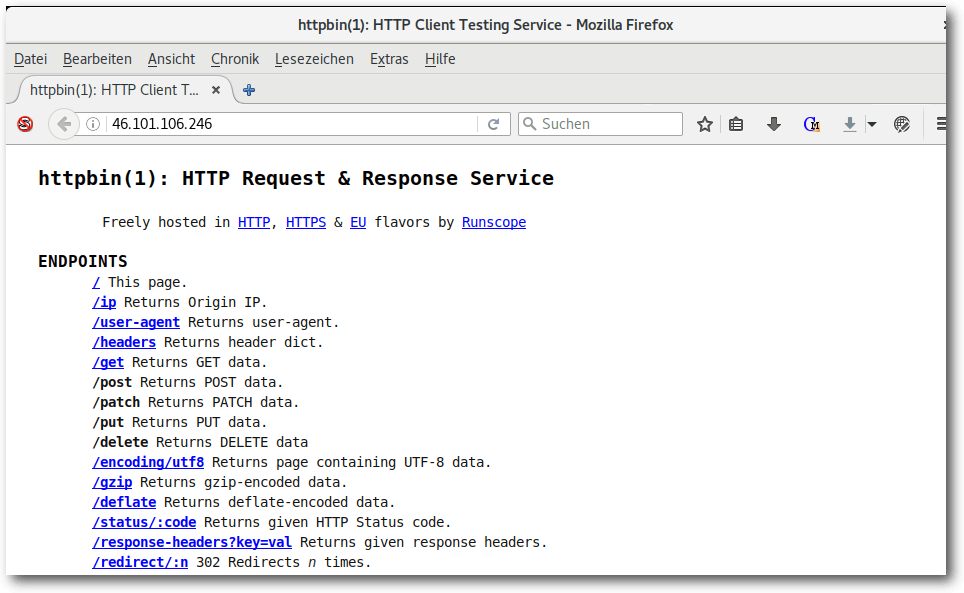

„Pipeline as Code“ wird das Verfahren genannt, womit die komplette Konfiguration eines Jenkins-Jobs in einer Datei geschrieben werden kann. Eine Pipeline kann man als Workflow ansehen, bei dem verschiedene Schritte ausgeführt werden, um Dinge zu erledigen. Das beinhaltet bei einem Software-Projekt etwa das Bauen, Testen und ggf. auch die Veröffentlichung und das Deployment der Software. Das Skript wird in Groovy geschrieben und in der Regel mit dem Dateinamen Jenkinsfile im Repository abgespeichert. Alleine das Versionieren im Repository bringt schon einen Vorteil; so kann ohne Probleme ein älterer Stand des Repositorys ausgecheckt werden und das Projekt in Jenkins mit der damaligen Konfiguration gebaut werden. Bei der Nutzung von Jenkins ohne Pipelines war dies nicht möglich, da die Skripte separat im Job definiert wurden und in der Regel nicht mit dem Projekt synchronisiert wurden. Mit einem Jenkinsfile soll die komplette Konfiguration eines oder mehrerer Jobs in einem Jenkinsfile zusammenfließen. Wo man vorher ggf. mehrere einzelne Jobs definiert hat, die verschiedene Dinge erledigen, kann das nun in einer Pipeline und somit in einem Jenkins-Job geschehen. Pipelines haben aber auch noch weitere Vorteile, so können Pipelines beliebig pausiert werden und auch einen Neustart des Jenkins-Masters „überleben“ – egal, ob er geplant oder ungeplant war. Dies ist insbesondere bei Updates nützlich, denn Updates von Jenkins selbst und der Jenkins-Plug-ins erfordern einen Neustart des Dienstes, was nur geht, wenn keine Jobs laufen oder diese sich pausieren lassen. Bei kleinen Jenkins-Installationen, bei denen nur wenige Jobs definiert sind und nur selten Jobs angestoßen werden, ist das wohl kein großer Vorteil. Bei großen Installation mit zahlreichen parallel laufenden Jobs schon eher. Um mit Pipelines sinnvoll arbeiten zu können, gibt es drei Begriffe, die bekannt sein müssen: Steps, Nodes und Stages. Ein Step ist nicht viel mehr als ein Task, der einen Teil einer Ausführung darstellt. Er sagt Jenkins quasi, was zu tun ist. Nodes sind generell die vorher bekannten Jenkins-Slaves, also Rechner, auf denen Jenkins-Jobs ausgeführt werden können. Im Pipeline-Kontext haben diese eine etwas andere zusätzliche Bedeutung. In einem Jenkinsfile können ein oder mehrere Node-Blöcke definiert werden. Jeder Node-Block wird zur Jenkins-Build-Queue hinzugefügt, wodurch diese an passende Nodes verteilt werden. Dort wird dann zusätzlich der Workspace vorbereitet, in dem häufig auch das Repository geklont bzw. ausgecheckt wird. So kann man in einem Jenkinsfile beispielsweise hundert Nodes definieren, die gegen einen zentralen Server Requests schicken und die Antworten auswerten. Dies ging vorher zwar schon mit Multikonfigurationsprojekten, doch war es dort auch etwas umständlicher. Der letzte Teil ist ein Stage. Eine Pipeline kann aus mehreren Stages bestehen, die eigene Aufgaben erledigen. Um das Beispiel mit dem Bauen und Testen eines Software-Projektes fortzuführen, kann man etwa drei Stages definieren: einen zum Bauen, einen zum Testen und einen zur Testauswertung des Projektes. Die Stages werden im Job definiert, sodass man sieht, wie lange ein Stage dauert und ob dort etwas schief gegangen ist.Eine Pipeline schreiben

Bislang wurde rein die Theorie der Pipeline behandelt. Spannender wird es, wenn eine Pipeline geschrieben wird. Voraussetzung ist eigentlich nur, dass ein Jenkins-Server mit dem Pipeline-Plug-in installiert ist. Anschließend muss über das Hauptmenü „Element anlegen“ eine Pipeline ausgewählt werden, die dann einen passenden Pipeline-Job anlegt. Für den Anfang ist es immer besser, die Pipeline innerhalb eines Jobs zu definieren, statt sie direkt in ein Repository zu legen, da sonst sehr häufig bei Änderungen für Kleinigkeiten eingecheckt werden muss. Das folgende Beispiel zeigt eine ganz einfache Pipeline, die nicht viel mehr macht als die Ausgabe von „Hello World!“:

node {

echo 'Hello World!'

}

Dieses zugegeben einfache Beispiel führt auf einem beliebigen Node zur

Ausgabe von „Hello World!“. Man kann node auch noch einen Parameter

übergeben, welcher den Namen des Nodes darstellt, auf dem der Code

ausgeführt werden soll. Das sieht etwa so aus:

echo 'Hello World!'

}

node("ubuntu1604") {

echo 'Hello World from Ubuntu!'

}

Damit das auch ausgeführt wird, muss allerdings ein Node mit dem

Namen oder Label ubuntu1604 existieren. Ansonsten wartet die Pipeline ewig, bis ein

solcher Node verfügbar ist.

An dieser Stelle wäre es zwar möglich, die komplette Pipeline-Syntax

herunterzuschreiben, allerdings wäre das wohl etwas viel. Eine

wichtige Quelle, um die richtige Syntax zu lernen und alle Funktionen zu finden,

ist der „Snippet Generator“. Dieser ist in jedem Pipeline-Job zu finden, wenn man

im Hauptmenü auf „Pipeline Syntax“ klickt.

echo 'Hello World from Ubuntu!'

}

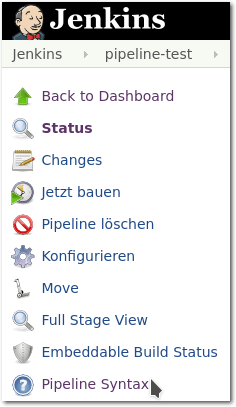

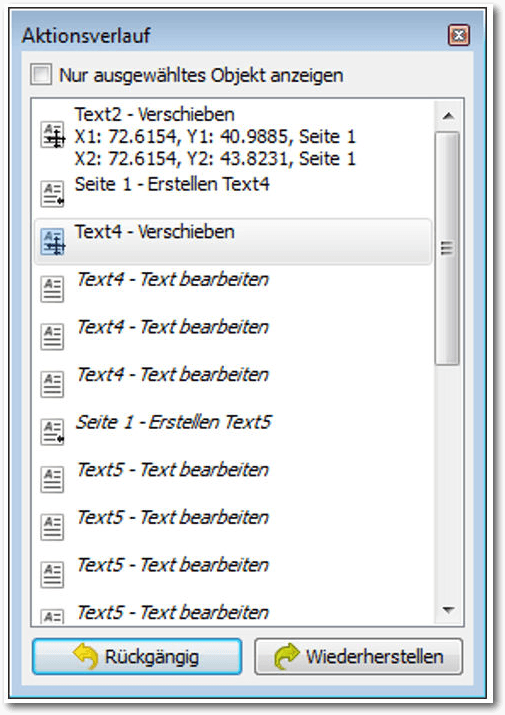

Pipeline-Syntax im Menü.

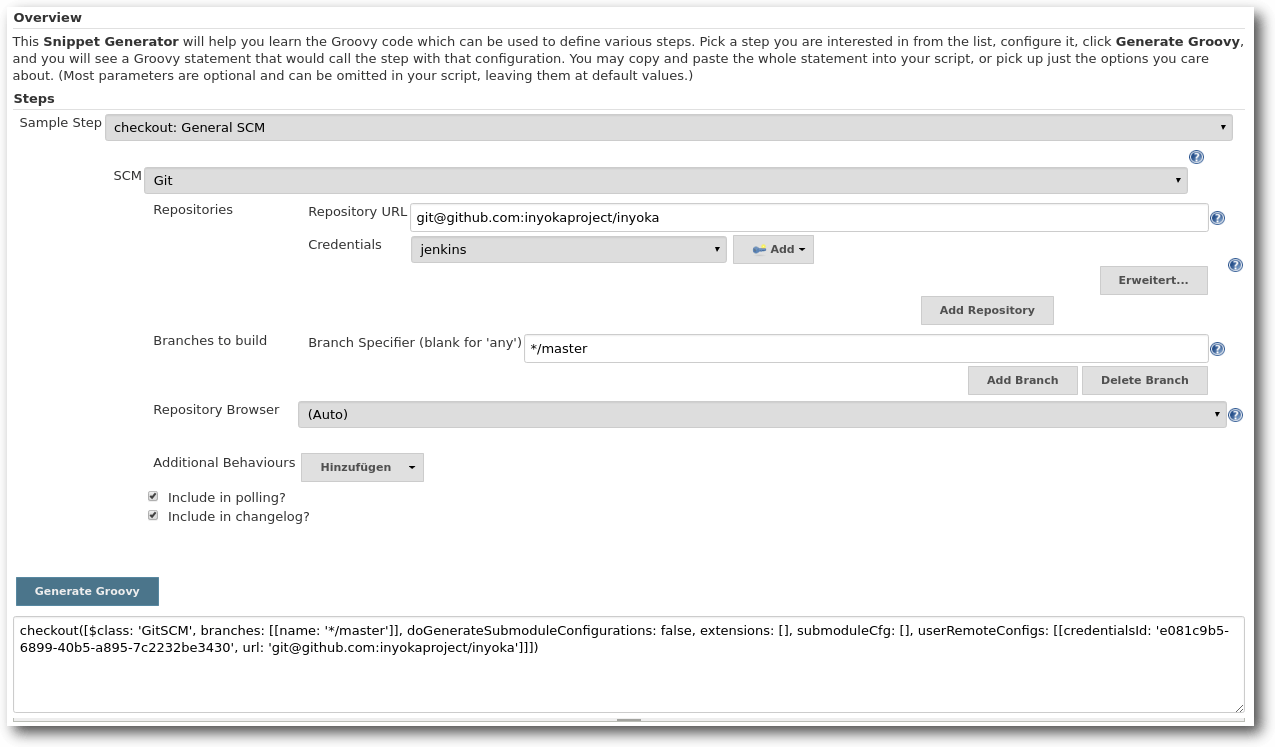

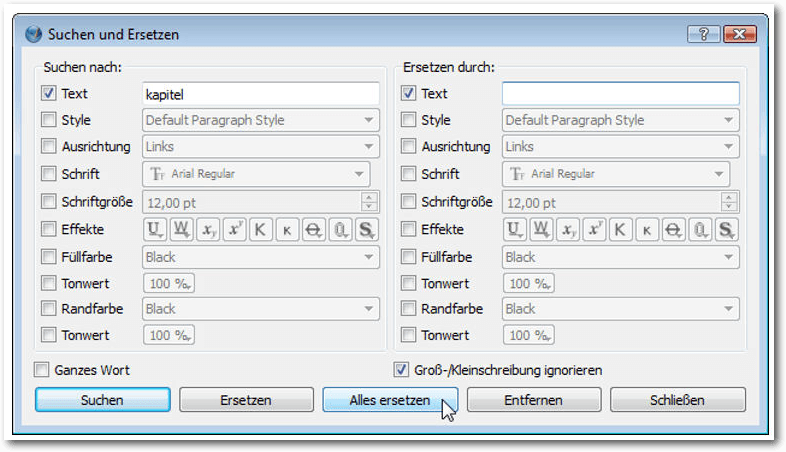

Dort findet sich ein Drop-Down-Menü, in dem verschiedene Build-Schritte und Aktionen über diverse Formulare zusammengeklickt werden können. Dies ist sehr oft sehr hilfreich, weil man auch nach längeren Arbeiten mit der Pipeline-Syntax sich diese nicht so einfach einprägen kann. Das liegt auch daran, dass viele Plug-ins ihre eigenen Befehle und Parameter mitbringen, die man sich fast unmöglich merken kann. Ansonsten gilt, dass der Code in Groovy geschrieben wird und dessen Sprachelemente ebenfalls genutzt werden können.

Der Snippet Generator ermöglicht die Generierung von Groovy-Code.

Interessant werden Pipelines, wenn mehrere Stages existieren, welche die Ausführung der Pipeline sinnvoll gruppieren:

node {

stage('Checkout') {

checkout scm

}

stage('Build') {

sh '''cmake .

make -j2'''

}

stage('Tests') {

sh './run_tests'

}

}

Durch die Umsetzung der Jobs in Pipelines wurden viele Nachteile aus Jenkins

1.x ausgebessert. Einige Features sind allerdings noch nicht – oder nur

anders – mit Pipelines möglich. So lassen sich aktuell etwa keine Stages

innerhalb von Stages schachteln. Es existiert auch keine direkte

Möglichkeit, um Multikonfigurationsprojekte umzusetzen. Letzteres sind Jobs,

die mit verschiedenen Konfigurationen ausgeführt werden, also etwa Tests

einer Software mit verschiedenen Einstellungen. Dies ist etwa dann

notwendig, wenn man die Software über verschiedene Linux-Distributionen oder

gar Betriebssysteme hinweg testet und trotzdem noch übersichtlich sehen

will, ob ein bestimmtes System noch Probleme hat.

stage('Checkout') {

checkout scm

}

stage('Build') {

sh '''cmake .

make -j2'''

}

stage('Tests') {

sh './run_tests'

}

}

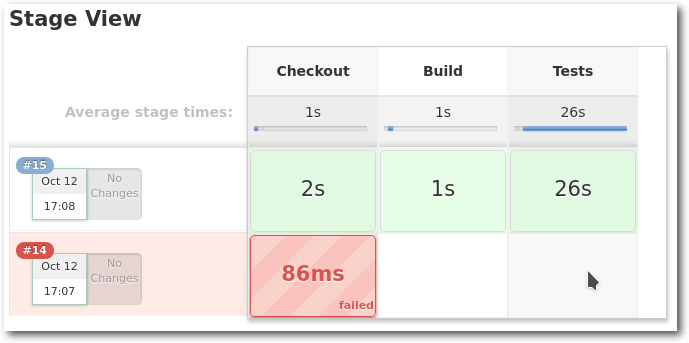

Ansicht der Stages der Pipeline.

Je nachdem wie intensiv man Jenkins nutzt, kann es also durchaus sein, dass sich noch nicht alle bisherigen Jobs in Pipelines umsetzen lassen. Da muss man wohl noch auf einige weitere Features und Verbesserungen warten. Pipelines bilden trotzdem die wesentliche Grundlage für die zukünftige Nutzung von Jenkins. Sie sind nicht unbedingt einfach zu schreiben, lassen sich aber durch die Nutzung des Snippet-Generators trotzdem mit vielen kleinen Schritten schreiben. Pipelines sind auch wesentlicher Bestandteil der nächsten drei Funktionen, die vorgestellt werden.

Multibranch-Pipeline

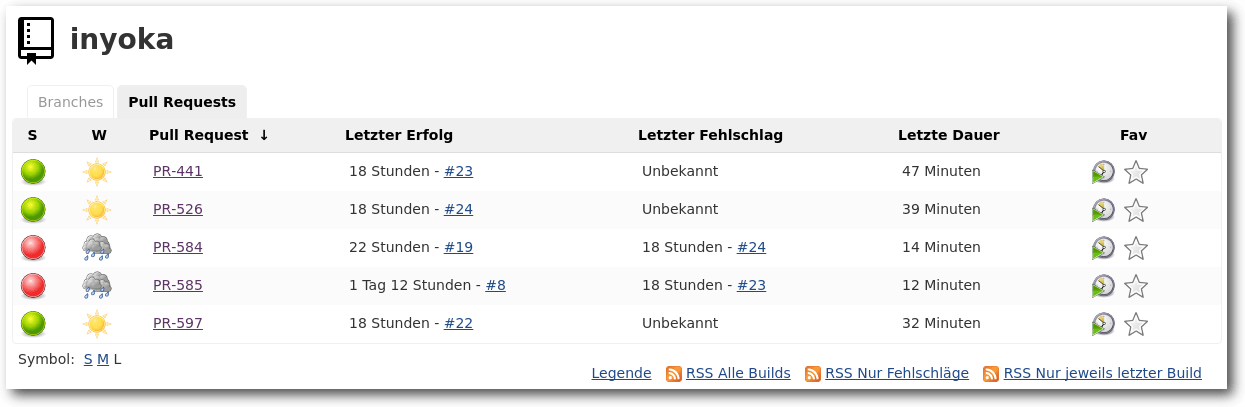

Ein weiterer Nachteil bei Jenkins 1.x war, dass man für so gut wie jeden Branch einen eigenen Job brauchte, wenn dieser gebaut und getestet werden sollte. Dadurch, dass man ein Jenkinsfile geschrieben hat, liegt die Konfiguration des Jobs schon im Repository, was an dieser Stelle einfach für jeden Branch, den man haben möchte, genutzt werden kann. Theoretisch kann man auch weiterhin einzelne Jobs für einzelne Branches anlegen, die dann jeweils das Jenkinsfile anlegen. Aber auch das wäre eher umständlich, da nicht benötigte Entwicklungsbranches mit ihren Jobs immer wieder gelöscht werden müssen. Hier kommt das Multibranch-Pipeline-Plug-in ins Spiel. In dem Job definiert man nur, welches Repository eingelesen werden soll. Anschließend scannt Jenkins das komplette Repository, um alle Branches mit einem Jenkinsfile zu finden. Daraus erzeugt Jenkins dann dynamisch eigene Jobs, was viel Konfigurations- und Wartungsarbeit verhindert. Bei gelöschten Branches löscht Jenkins automatisch auch den dynamisch generierten Job. Wesentlicher Nachteil dieser Lösung ist, dass jedes Repository einzeln konfiguriert werden muss. Dafür gibt es aber auch eine Lösung, jedenfalls für GitHub.GitHub Organization Folder Plugin

Das „GitHub Organization Folder Plugin“ geht das Problem an, dass man für jedes Repository einen eigenen Job anlegen muss, wovon dann die Jenkinsfiles eingelesen werden. Mit diesem Plug-in wird nicht nur ein Repository, sondern die ganze GitHub-Organisation gescannt. Jenkins legt dann einen Ordner an, in dem alle Repositories mit allen Branches, die ein Jenkinsfile enthalten, aufgelistet werden. Weiterhin konfiguriert Jenkins ebenfalls das automatische Bauen bei Pull-Requests. Zuvor müssen Jenkins die entsprechenden Rechte für die GitHub-Organisation gegeben werden, damit dieser den Pull-Request auslesen darf. GitHub-Organisation umfasst dabei nicht nur die Organisationen von GitHub, sondern auch normale Benutzer-Accounts. Das Plug-in erleichtert die Einrichtung von GitHub-Repositories einer Organisation in Jenkins deutlich, da eine Konfiguration von einzelnen Repositories und Pull-Requests nicht notwendig ist. Dies ist im Zusammenhang mit der erleichterten initialen Einrichtung ein weiteres Feature, was die Konfiguration und Administration deutlich erleichtert. Leider gibt es diese Funktion nur für GitHub. Für andere Git-Hostingdienste ist es leider nicht verfügbar, könnte aber theoretisch mit den nötigen Kenntnissen selbst implementiert werden, wenn APIs auf der Gegenstelle verfügbar sind.

Pull-Request-Ansicht im GitHub-Projekt.

Blue Ocean

Die Web-Oberfläche von Jenkins funktioniert zwar prinzipiell, ist allerdinga an vielen Stellen nicht besonders benutzerfreundlich und auch nicht mehr auf Höhe der Zeit. Blue Ocean nennt sich das Projekt, welches eine neue, frische und moderne Oberfläche für Jenkins bringen soll und speziell für Pipelines optimiert ist. Zur Zeit befindet sich Blue Ocean in einer Beta-Phase für die erste Version und kann noch recht wenig. Blue Ocean wird wie so vieles von Jenkins in Plug-ins entwickelt und ausgeliefert. Im Moment kann es vor allem eins: Jobs alphabetisch auflisten und den Build-Status mit Konsolen-Ausgaben von Pipelines übersichtlich darstellen.

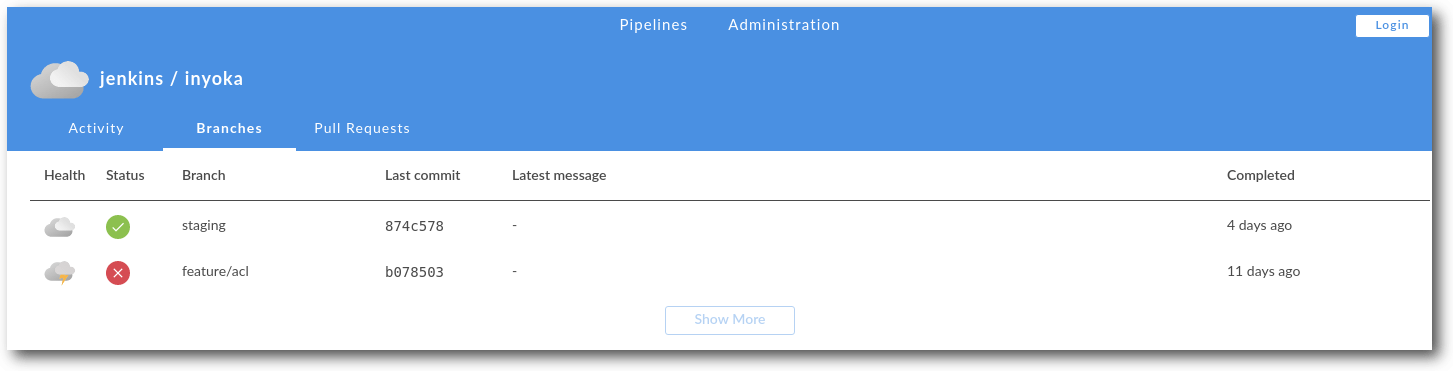

Die Übersicht über den Status der Branches in einem Repository.

Für den alltäglichen Betrieb stößt man bei Blue Ocean schnell an seine Grenzen, da vieles nicht möglich ist oder noch nicht zur Verfügung steht. Allem voran lassen sich keine administrativen Dinge erledigen. Das betrifft nicht nur die Jenkins-Server-Konfiguration, sondern auch die Konfiguration und das Anlegen von Jobs. In Zukunft werden in Blue Ocean mehr und mehr Funktionen einfließen – und dabei nicht nur Funktionen der altbewährten Oberfläche. Später sollen sich Pipelines auch einfacher und hübscher über Blue Oceans anlegen lassen. Bis es allerdings soweit ist, dürfte es noch einige Zeit dauern. Immerhin läuft Blue Ocean unter einer eigenen URL und lässt sich parallel zum Standard installieren und nutzen.

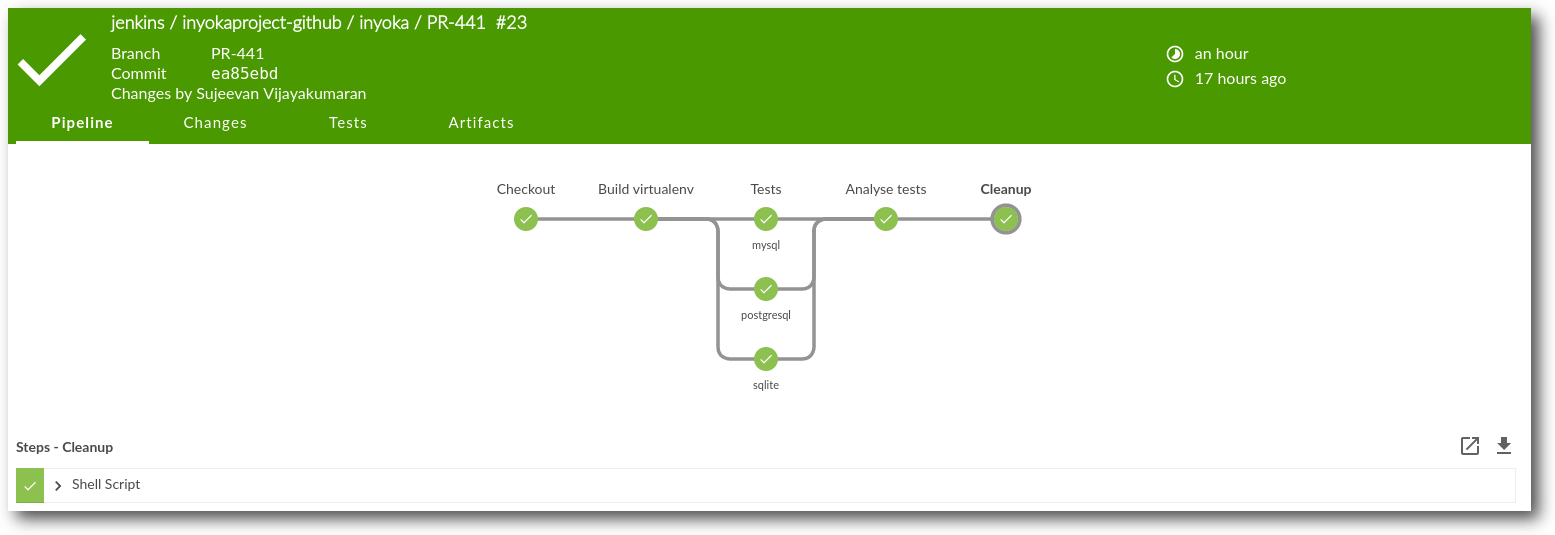

Pipeline in Blue Ocean mit parallelen Ausführungen.

Fazit

Mit Jenkins 2.0 wurden einige Neuerungen eingeführt, die die tägliche Nutzung angenehmer gestalten und einige neue Nutzungsmöglichkeiten bringen. Mit Blue Ocean wird zudem an einer frischen Oberfläche gearbeitet, die einiges angenehmer und hübscher macht. Es gibt allerdings auch viele Alternativen wie GitLab CI [3] oder Travis-CI [4], die auch jeweils einzelne Vor- und Nachteile haben. Links[1] https://jenkins.io/

[2] http://www.freiesmagazin.de/freiesMagazin-2013-01

[3] https://about.gitlab.com/gitlab-ci/

[4] https://travis-ci.org/

Autoreninformation |

| Sujeevan Vijayakumaran (Webseite) nutzt Jenkins seit etwa fünf Jahren beruflich und hat schon viele Test-Infrastrukturen mit Jenkins aufgebaut. |

Beitrag teilen Beitrag kommentieren

Zum Inhaltsverzeichnis

openSUSE Leap 42.2

von Mirko Lindner Nachdem mit openSUSE Leap 42.1 der freien Gemeinschaftsdistribution teilweise nur ein mäßiger Hüpfer gelang und das Produkt vor allem auf dem Desktop anfänglich nur wenig überzeugte (siehe freiesMagazin 01/2016 [1]), folgt nun mit der Version 42.2 die erste Aktualisierung. Wie immer will das Team mit der aktuellen Version eine noch bessere, einfachere und stabilere Distribution herausgebracht haben. So verspricht openSUSE auch dieses Mal, mit dem Produkt ein weitgehend universelles System für Desktop-, Netbook- und Serveranwender zu liefern. Der Artikel wirft einen Blick auf die Distribution in einem Langzeittest in einer produktiven Umgebungen. Redaktioneller Hinweis: Der Artikel „OpenSuse Leap 42.2“ erschien erstmals bei Pro-Linux [2].Einführung

Mit der Version 42.2 von openSUSE [3] erscheint nun erstmals eine erste Aktualisierung der Distribution, die dem neuen Veröffentlichungsschema folgt. Wie bereits bei openSUSE 42.1 angekündigt, stellt die neue Version keine vollständige Neuentwicklung mehr dar, sondern eine partielle Aktualisierung der bestehenden Generation. Denn während die Basis der Distribution nur wenige größere Änderungen erfuhr, wurde vor allem der nach außen sichtbare Desktop einem massiven Update unterzogen. Grund für die unterschiedliche Aktualisierungsstrategie ist die Arbeitsteilung innerhalb des Projekts. Bereits im Frühsommer 2015 hatte das hinter dem Projekt stehende Nürnberger Unternehmen SUSE angekündigt [4], die Entwicklung von openSUSE direkt zu unterstützen und einen Großteil der Quellen von SUSE Linux Enterprise (SLE) auch in den openSUSE-Build-Service (OSB) einzuspeisen. Die Idee dahinter war, dass SUSE sich um die Basis der Gemeinschaftsvariante kümmert und die freie Gemeinschaft den Desktop und die darauf aufbauenden Anwendungen im Rahmen von „Tumbleweed“ bereitstellt. Streng genommen stellt openSUSE Leap 42.2 deshalb eine Aktualisierung von openSUSE Leap 42.1 dar, deren Basis aus SUSE Linux Enterprise (SLE) 12 Service Pack 2 stammt. Wer bereits mit stabilen Versionen anderer Distributionen gearbeitet hat, sogenannten LTS- oder Enterprise-Varianten, wird sicherlich nichts Verwerfliches dabei finden, versprechen diese Produkte in der Regel Stabilität und eine langfristige Planbarkeit. Doch ist das auch bei openSUSE der Fall? Schließlich verwendet das Produkt nur als Basis einen Enterprise-Unterbau - der zudem im Vergleich zu openSUSE Leap 42.1 aktualisiert wurde.Lieferumfang

Mittlerweile gehört es zum guten Ton jedes Distributors, das eigene Produkt in verschiedenen Editionen auszuliefern. So kommt auch openSUSE Leap 42.2 in der aktuellen Version in mehreren Varianten – auch, wenn die Artenvielzahl mit der Einführung der neuen Strategie dezimiert wurde. Neben einer 4,7 GB großen DVD, die die Mehrzahl der verfügbaren Pakete in sich vereint, offeriert das Team auch ein kleineres Abbild für eine Netzwerkinstallation. Dedizierte Versionen für spezielle Einsatzbereiche oder Desktops stellt das Team nicht mehr bereit. Hier müssen Anwender auf die zahlreichen Abwandlungen der Distribution zurückgreifen, die im Zuge diverser Projekte entstanden sind, oder sich schlicht selbst eine passende Variante bauen. Die schon in der Vorgängerversion nicht mehr angebotene Live-Version ist auch dieses Mal entfallen. openSUSE liefert auch mit der neuen Version einen gewohnt großen Umfang an Paketen, der sich allerdings auf freie Software beschränkt. Anwender, die auch proprietäre Zugaben wünschen, müssen diese aus einem Online-Verzeichnis installieren. Diese Unterteilung wurde bereits in openSUSE 11.1 (siehe freiesMagazin 03/2009 [5]) eingeführt und soll es sowohl Entwicklern als auch Drittherstellern erleichtern, auf openSUSE aufbauende, freie Produkte zu erstellen. Die Softwareausstattung ist SUSE-typisch üppig ausgefallen. Zur Grundausstattung gehören neben dem Basissystem, diverse Desktops, Server und Tools. Verschwunden aus der Installation sind allerdings Seamonkey, der sich nicht mehr kompilieren lässt, Dropbear, der laut Aussage des Herstellers keine Vorteile gegenüber openssh bietet, und das nicht mehr funktionierende Algebra-System Cadabra.

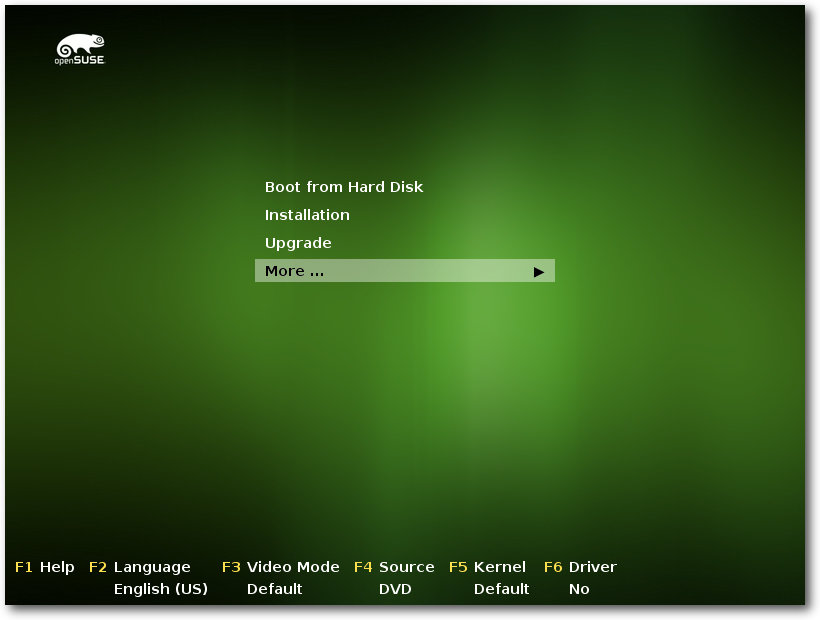

Start der Installation.

Installation

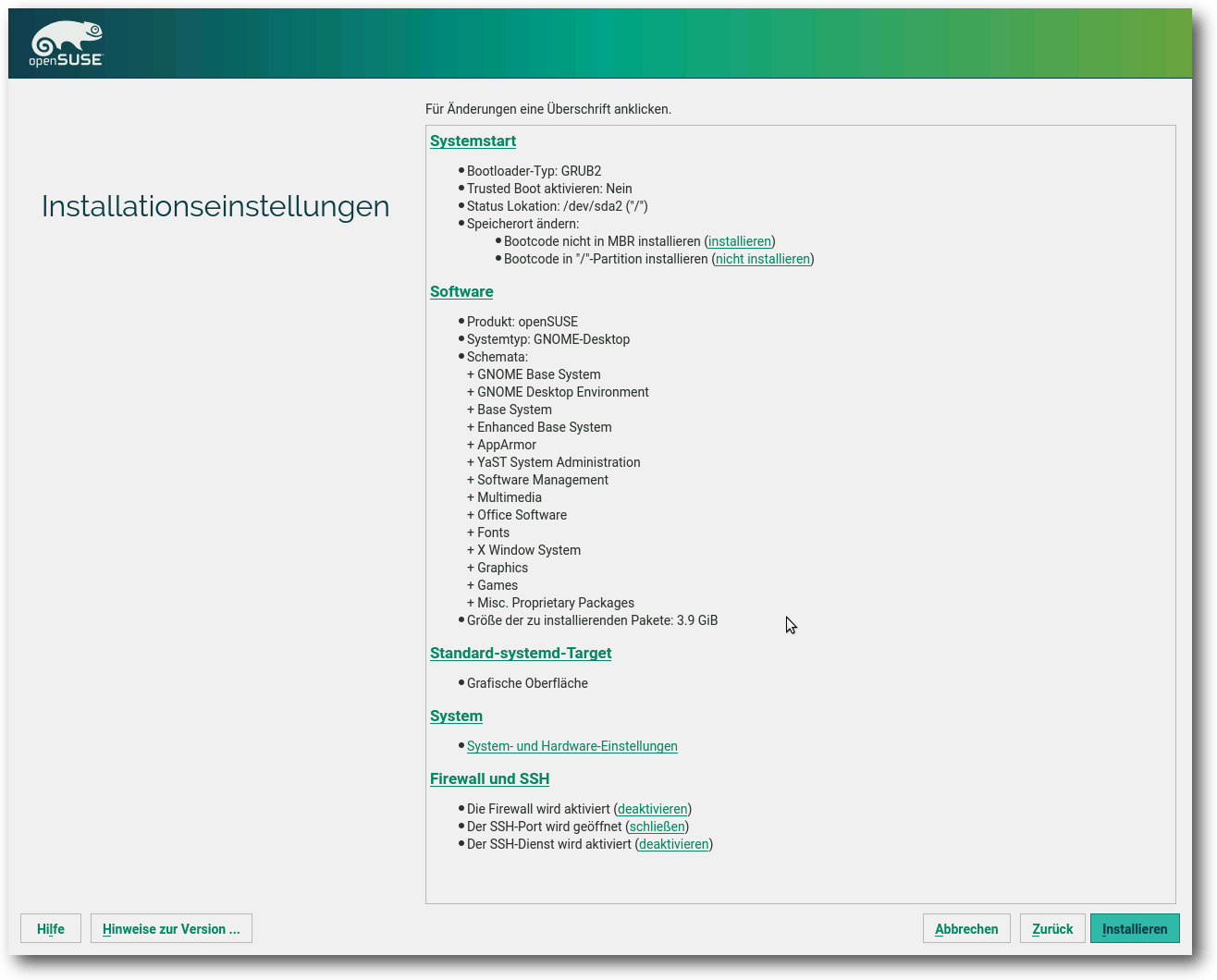

War die Installation einer Linux-Distribution anfänglich etwas für Spezialisten, so hat Linux diesbezüglich mittlerweile neue Standards gesetzt, an denen sich auch andere Betriebssysteme orientieren. Alle großen Linux-Distributionen haben viel Entwicklungszeit in die Verbesserung des Installationsprozesses gesteckt, sodass eine Linux-Installation kaum noch Probleme bereiten sollte. Fast alle Anbieter konzentrieren sich deshalb auf die Pflege der Werkzeuge. So auch openSUSE 42.2. So war es kaum verwunderlich, dass auch die neue Version der Distribution kaum Probleme bei der Installation verursachte. Bei der Installation auf einem Desktop, einem Laptop oder einer virtuellen Maschine wurde die komplette Hardware einwandfrei erkannt und sinnvoll (vor)konfiguriert. Es sollte allerdings erwähnt werden, dass die hier durchgeführten Tests keinesfalls eine Referenz darstellen und lediglich einen Ausschnitt wiedergeben – je nach Hardware und Peripherie kann sich die Installation natürlich unterschiedlich verhalten und Probleme sind sicherlich nicht ausgeschlossen. Funktionell gesehen unterlag die Auswahl der möglichen Installationsmethoden keinerlei Änderung – auch wenn die Auswahlmaske beim Start geringfügig verändert wurde. So bietet openSUSE immer noch eine automatische Installation mit verschiedenen Kernelparametern, darunter deaktivierten ACPI, eine Upgrade-Option, Rettungssystem oder Speicher- oder Installationstest zur Auswahl an. Darüber hinaus lassen sich schon bei der Auswahl der Installation die Sprache und die zu verwendende Auflösung festlegen. Die eigentliche Installation gleicht vom Ablauf her, von kleineren Ausnahmen abgesehen, der von openSUSE Leap 42.1. Neu sind unter anderem ein leichterer Import von Mount-Optionen und eine geringfügige Umgestaltung der Softwareauswahl. Der ehemals etwas versteckte Server-Modus wurde nun auf die Startseite gehoben und firmiert nicht mehr unter dem Label „Minimalinstallation“. Zudem lässt sich bei der Installation die Erstellung eines Standardnutzers logischer überspringen und die Installationsroutine bietet direkt bei der Installation „Trusted Boot“ als Optionsparameter zur Auswahl an. Bereits mit der Einführung von openSUSE kehrte die Distribution zu ihren Wurzeln zurück und wählte KDE als Standard aus. Auch die neue Version macht hier keine Ausnahme. So ist auch bei openSUSE Leap 42.2 KDE als Standarddesktop ausgewählt. Wer auf eine andere Umgebung aufsetzen möchte, kann dies mit nur einem Klick machen und zu GNOME oder Xfce wechseln. Nicht mehr enthalten bei der globalen Auswahl der Desktop-Systeme ist der LXDE-Desktop, der nun manuell in der Paketauswahl gewählt werden muss. Die eigentliche Konfiguration des Systems übernimmt immer noch das SUSE eigene Verwaltungswerkzeug Yast. Die Erkennung der vorhandenen Geräte beherrschte das Werkzeug gewohnt souverän. Zudem ist es möglich, dem Automatismus unter die Arme zu greifen und viele der Komponenten manuell zu konfigurieren. Hier hat die Distribution einen praktikablen Spagat geschafft, die sowohl Anfänger als auch Profis zufriedenstellen wird.

Zusammenfassung der Installation.

Das Basissystem

Die Distribution setzt auf den aus in SUSE Linux Exterprise (SLE) stammenden Kernel Kernel 4.4.27 auf und bietet dementsprechend auch die Vorteile der neuen Version von Linux. Die Neuerungen umfassen unter anderem Verbesserungen im Block-Layer, dem Netzwerkstack und bei der 3-D-Unterstützung im Virtual-GPU-Treiber. Etwa 75 Prozent der mehr als 11.500 Änderungen der Kernelversion betreffen Treiber. Unter dem hohen Anteil von Treiber-Updates ragen die Treiber aus dem Staging-Bereich, dem Netzwerk-Subsystem und die GPU-Treiber heraus. Diese drei Bereiche machen über die Hälfte aller Treiber-Änderungen aus. So unterstützen in der neuen openSUSE Leap 42.2 Loopback-gemountete Dateisysteme direkte und asynchrone Ein- und Ausgabe. LightNVM ermöglicht darüber hinaus die Verwaltung von SSDs auf niedriger Ebene und kann damit den Flash Translation Layer umgehen, was unter anderem zu einer gesteigerten Geschwindigkeit bei diversen SSD-Modellen führen soll. Das Blockgeräte-Subsystem unterstützt ferner einen NAPI-ähnlichen Mechanismus. Weitere Neuerungen des Kernels umfassen diverse Treiberaktualisierungen und Systemerweiterungen. Neu sind unter anderem Treiber für diverse USB-WLAN-Chips von Realtek und Fireware-Sound-Chips, darunter ein Audio-Treiber für Skylake-Notebooks mit einem über I2C eingebundenen Audio-Chip. Der Wacom-Treiber unterstützt weitere Intuos-Geräte und kommt auch mit Cintiq Companion 2 klar. Die AMD- und Intel-Grafiktreiber unterstützen einen integrierten Scheduler, der unter anderem Aktionen auf die Recheneinheiten des Grafikprozessors verteilen kann und damit die Leistung der Hardware steigert. Der Nouveau-Treiber kann zudem auf GDDR3-GPUs und GPUs der Baureihen G94 bis G200 die Energiesparmodi besser nutzen. Die eingesetzte Glibc-Version wechselte zu Version 2.22. In der letzten Version setzte die Distribution noch auf Glibc 2.19. Die weitere Basis der Distribution stellen Bash 4.3, dhcp 4.3.3, GCC 4.8 und Systemd 228 dar. Mit von der Partie sind zudem Vim 7.4, Cups 1.7.5, Alsa 1.1.2 sowie die Skriptsprachen Perl 5.18.2, PHP 5.5.14 und Python 2.7.12. Um den Speicherverbrauch der automatisch erstellen Snapshots zu verringern, hat das Team /var/cache auf ein separates Btrfs-Subvolume ausgelagert. Laut Aussage der Entwickler beherbergt das Verzeichnis eine nicht unerhebliche Anzahl an Dateien, die sich allerdings schnell ändern und mühelos regeneriert werden. Aus diesem Grund sei es nicht wirklich notwendig, die Daten in das Snapshot-Konzept zu übernehmen. Anwender, die ihr System von einer früheren Version aktualisieren, sollten deshalb die Änderungen manuell nachpflegen. Wie das funktioniert, beschreiben die Release-Notes von openSUSE Leap 42.2 [6].KDE Plasma 5 – Der Standarddesktop

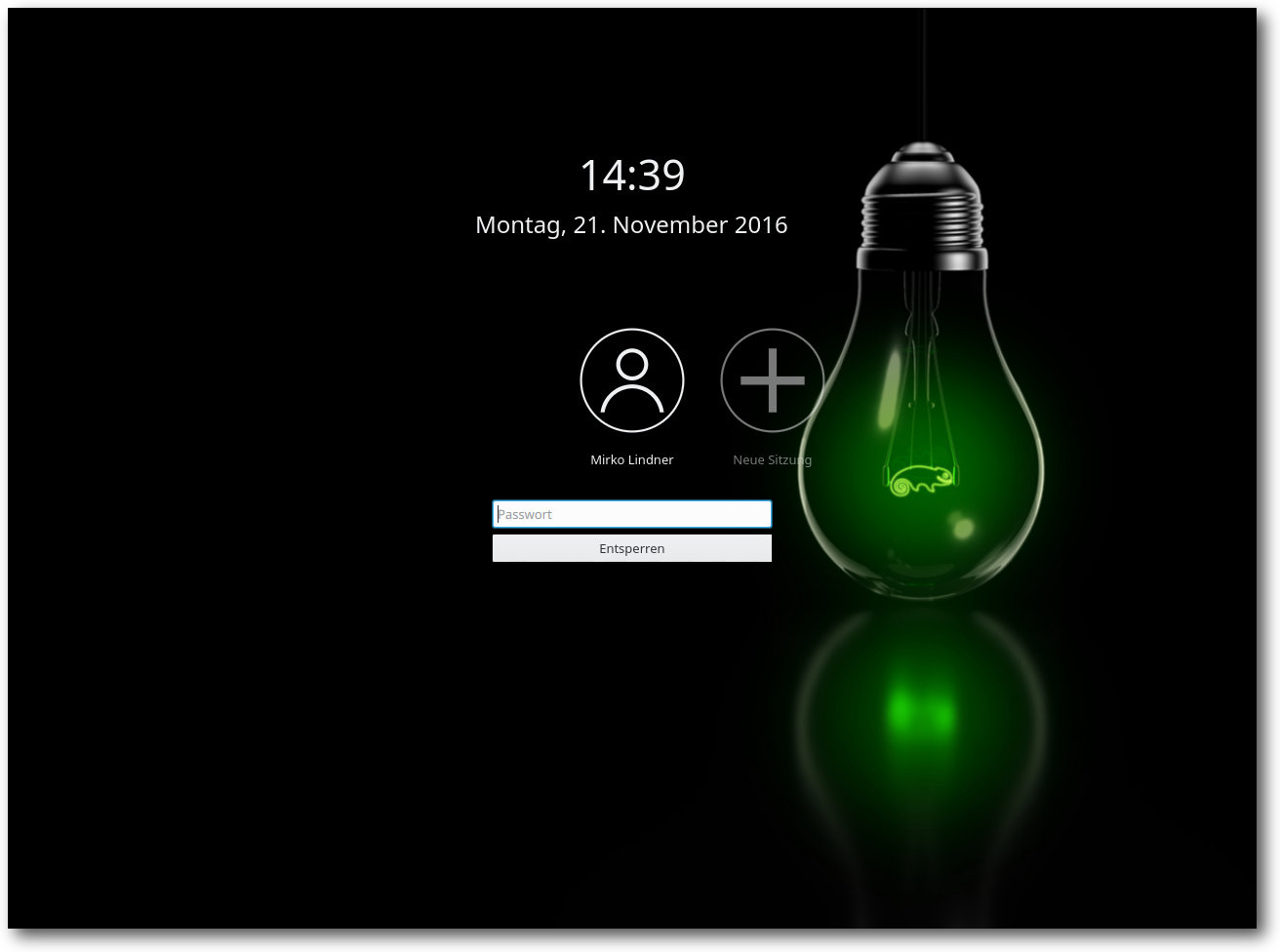

Der Standard-Desktop unter openSUSE wurde auch in der aktuellen Version durch die KDE-Gemeinschaft bereitgestellt. KDE Plasma 5 trägt nun die Versionsbezeichnung 5.8.2 und stellt die erste LTS-Version des KDE-Projekts dar. Demnach wird Plasma 5.8 für mindestens 18 Monate gepflegt. Die zugrunde liegende Version 5.6 von Qt wird für mindestens drei Jahre gepflegt, was für eine stabile Grundlage sorgen sollte. Dementsprechend lange dürfte die aktuelle Version die openSUSE-Anwender auch begleiten – sofern sie beim Standardumfang der Distribution bleiben und keine Fremdquellen nutzen. Gegenüber der noch in openSUSE Leap 42.1 eingesetzten Version stellt Plasma 5.8 einen großen Sprung dar. Die wohl wichtigste Eigenschaft der aktuellen Version ist, dass die Umgebung durch die Entwickler weitgehend stabilisiert wurde. Bemängelten wir noch beim Test von openSUSE Leap 42.1 die teilweise noch heftigen Fehler und Unzulänglichkeiten, so kann die aktuelle Version ruhigen Gewissens als produktionsreif bezeichnet werden. Zu den nun seit der letzten openSUSE-Version eingeführten Anwendungen gehört das „Wetter-Widget“. Zudem führt die aktuelle Version der Umgebung ein neues, leichteres Theme namens „Breeze Light“ ein und ändert das grafische Aussehen von Tooltips. Der Taskmanager zeigt den Fortschritt einer gerade durchgeführten Aktion, wie beispielsweise eines Kopiervorgangs oder Downloads, im Hintergrund an. Eine weitere Neuerung ist die Anzeige von Album-Informationen anstelle der Playervorschau im Taskmanager. Zudem wurde schon in Plasma 5.6 das „Media Controls“-Applet überarbeitet und Krunner unterstützt Drag and Drop. Das Pager-Applet und die Fensterliste wurden ferner neu geschrieben, um das in Plasma 5.7 neu eingeführte Task-Manager-Backend zu nutzen. Weiterhin wurde das Design des Login-Bildschirms angepasst, weshalb auch der Begrüßungsbildschirm von openSUSE einen frischeren Anstrich spendiert bekam. Als Stil für die Bedienelemente und Symbole kommt auch in openSUSE Leap 42.2 „Breeze“ zum Einsatz. Der Desktop selbst wirkt beim ersten Start aufgeräumt und nicht überladen. Neben einem Home- und einem Trash-Icon weist die Oberfläche keine weiteren Icons auf. Dasselbe gilt für den Hintergrund, der nur aus dem Standardartwork und dem Next-Hintergrund des KDE-Projektes besteht. Der Standardbrowser unter openSUSE Leap 42.2 ist weiter Firefox, der standardmäßig in der Version 49.0.2 ausgeliefert wird und über aktivierte Plug-ins für den OpenH264-Codec, IcedTea und Skype-Plug-ins verfügt.

Plasmas Sperrbildschirm.

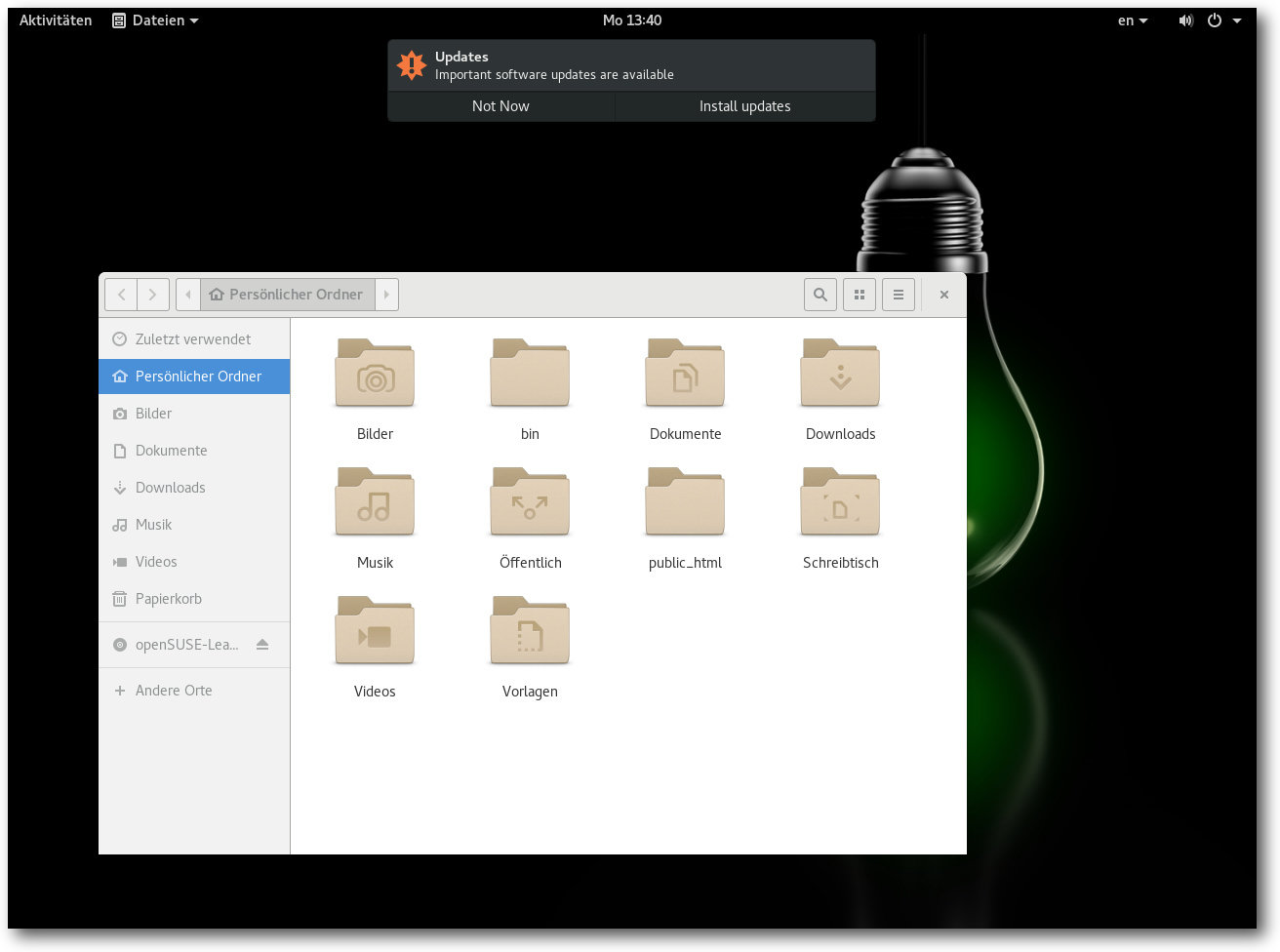

GNOME 3 – Der Alternativdesktop

Neben dem Standarddesktop des KDE-Projektes liefert openSUSE auch den zweiten großen Desktop, GNOME, mit. Bei der Umgebung hinkt openSUSE allerdings dem momentanen Stand der Entwicklung etwas hinterher und implementiert nicht die neueste verfügbare Version 3.22, sondern das über ein halbes Jahr ältere GNOME 3.20.1. Wie auch schon bei der KDE-Umgebung, werden auch unter GNOME neben den zahlreichen Standardanwendungen auch die meisten wichtigen Applikationen initial vorinstalliert. So werden neben Firefox auch LibreOffice 5.1.5.2 und GIMP 2.8.18 mitinstalliert. Der Desktop selbst ist, konzeptbedingt, auch unter GNOME aufgeräumt. Im direkten Vergleich mit der noch in openSUSE Leap 42.1 eingesetzten Version wurde GNOME erheblich verbessert. Mehrere hundert Entwickler haben den Versionssprung von GNOME 3.16 auf die neue Version begleitet. Eine der größeren Änderungen in GNOME 3.18 war beispielsweise die Einbindung von Google Drive. Die Seitenleiste im Dateimanager, die auch in Dateidialogen angezeigt wird, wurde überarbeitet und ein neuer Ort namens „Andere Orte“ liefert eine Übersicht über lokale Orte und Orte im Netzwerk. Ferner wurde der Kalender überarbeitet und auf Rechnern mit eingebautem Lichtsensor kann die Bildschirmhelligkeit jetzt automatisch angepasst werden. In GNOME 3.20 wurde Nautilus um eine verbesserte Suchfunktion erweitert. Zudem haben die Entwickler Maps funktional aufgewertet und besser an OpenStreetMap angepasst. Die Bildverwaltung Photos beherrscht unter anderem nicht-destruktives Editieren von Bildern und im Softwarecenter lassen sich nach der mit GNOME 3.18 eingeführten Funktion zum automatisierten Aktualisieren von Firmware in der neuen Version auch Aktualisierungen einer kompletten Distribution durchführen.

Der GNOME-Desktop.

Allgemein fällt allerdings in openSUSE auf, dass ähnlich KDEs Plasma auch GNOME weitgehend unverändert blieb. Abgesehen von einem veränderten Hintergrund und der Beigabe der eigenen Anwendungen wurde die Umgebung nur wenig verändert und gleicht weitgehend dem Standard, der seitens GNOME ausgeliefert wird. Das hat für die Entwickler der Distribution den Vorteil, dass sie nicht jede Version anpassen müssen und ein System ausliefern können, das den Wünschen der Desktop-Macher entspricht.

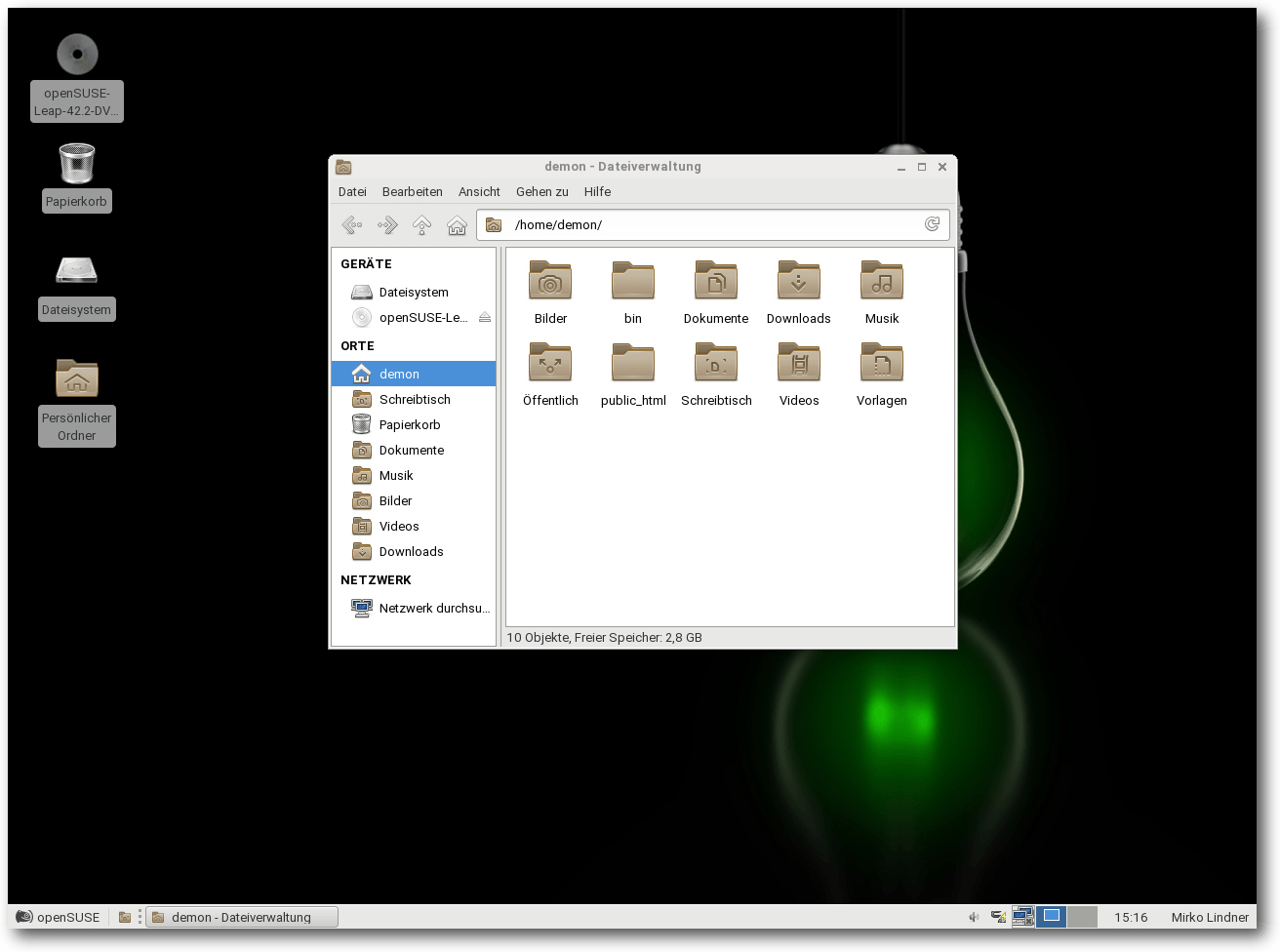

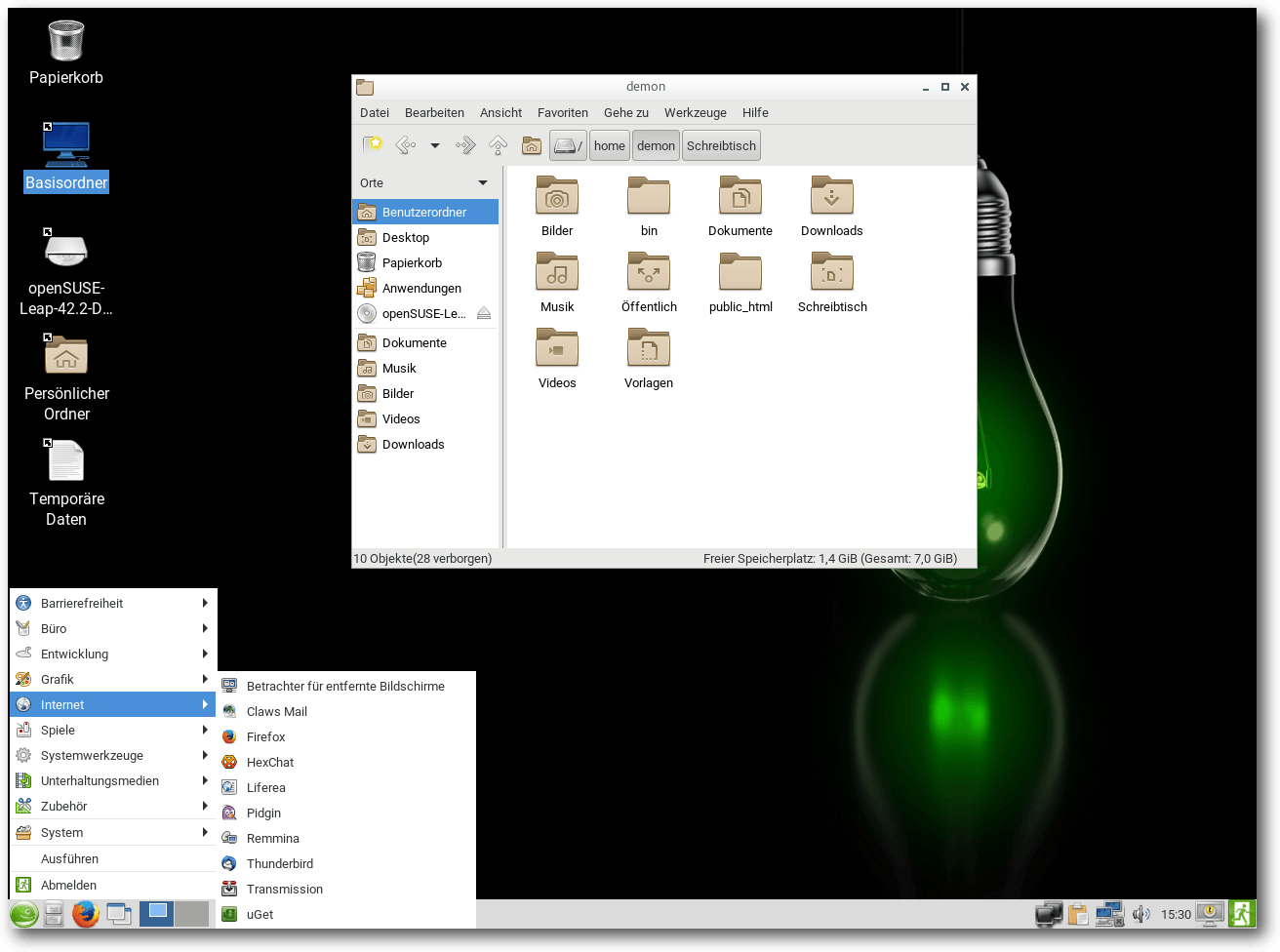

Weitere Desktops

Wie auch schon in den Vorgängerversionen bietet auch die aktuelle Version den Anwendern die Option, weitere Alternativen als Desktop zu verwenden. Mit von der Partie sind unter anderem MATE 1.16, Xfce 4.12, Enlightenment 0.21.3 und Cinnamon 3.0.7. Dabei ist auch LXQt 0.11.0, das über zahlreiche Verbesserungen an der Benutzerführung verfügt. Unter anderem führt es pavucontrol-Qt ein, eine Qt-Portierung von PulseAudios Mixer pavucontrol. Genauso wie GNOME und KDE präsentieren sich auch die Alternativdesktops aufgeräumt und sind an die Distribution angepasst.

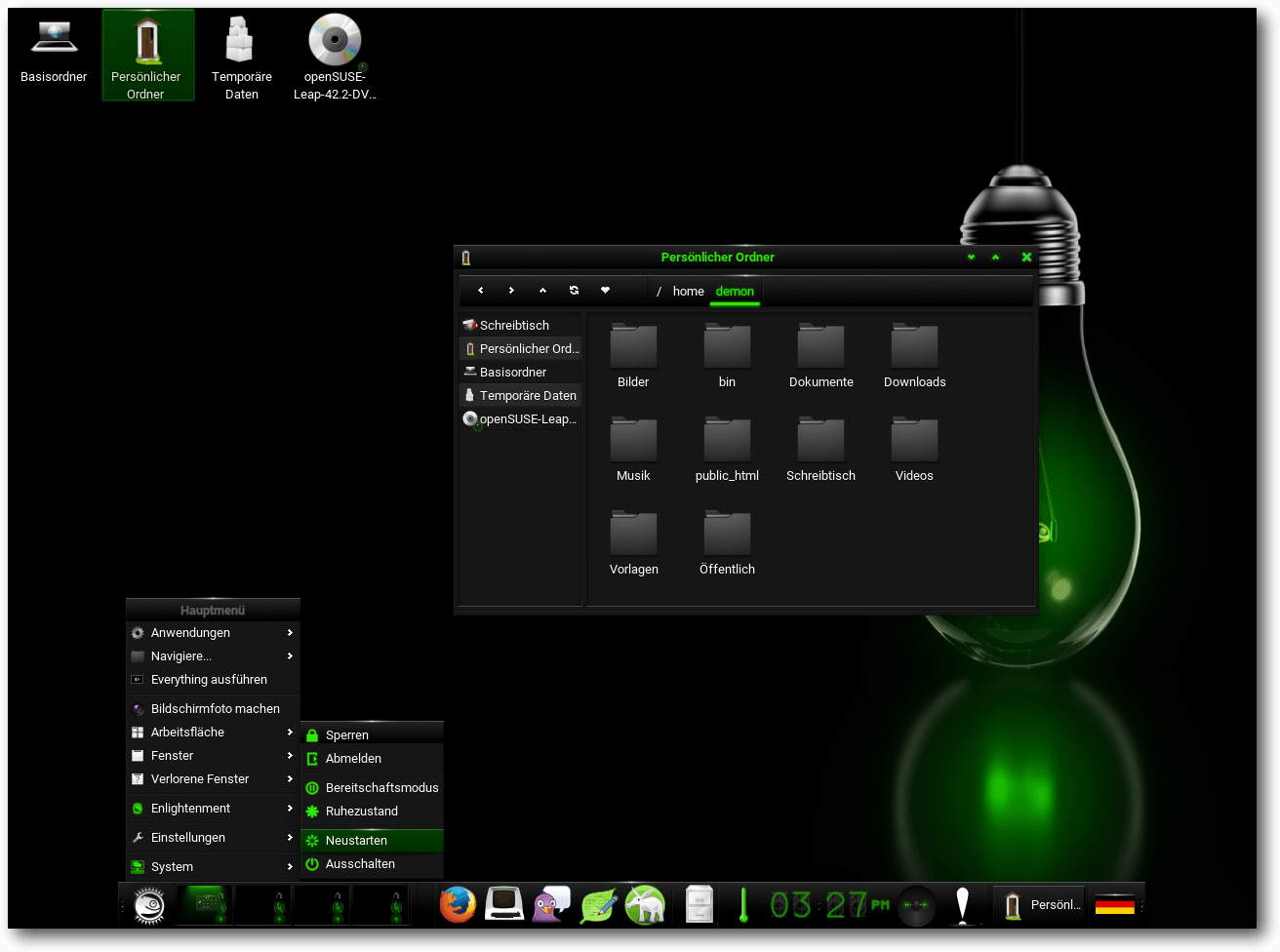

Der Xfce-Desktop.

Der LXDE-Desktop.

Der Enlightenment-Desktop.

Eine weitere Besonderheit der aktuellen Version von openSUSE stellt die Internationalisierung dar. So ist openSUSE Leap 42.2 die erste Version, die Weblate [7] zur Koordination der Übersetzung in die mittlerweile mehr als 50 Sprachen verwendet. Der Dienst erlaubt jedem Nutzer, am Übersetzungsprozess teilzunehmen und macht es unter anderem möglich, die Übersetzungen der Gemeinschaftsvariante mit denen für SLE besser zu koordinieren.

Serverinstallation und Yast

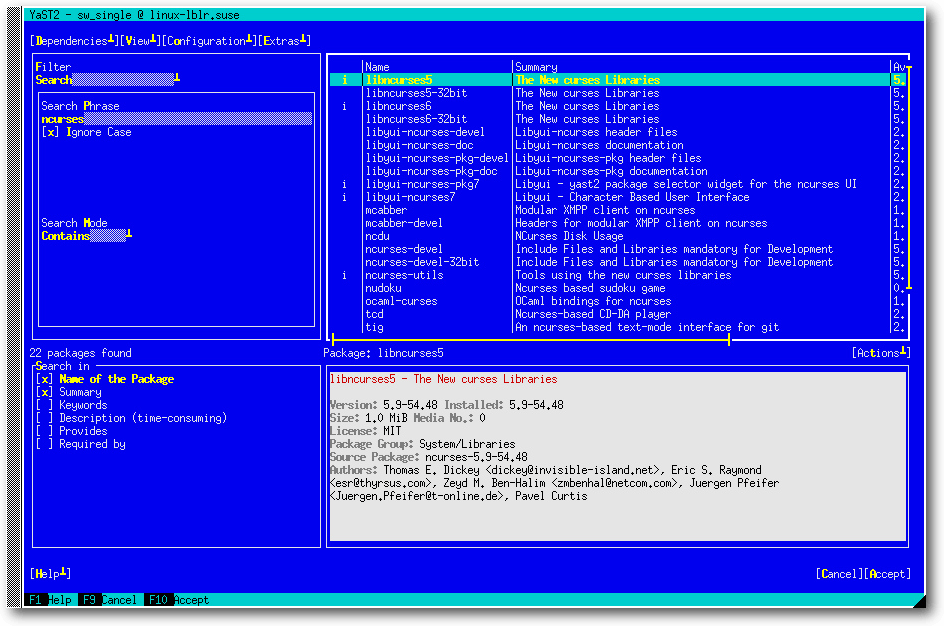

Am nahesten am Kern des SLE (SUSE Linux Enterprise) 12 Service Pack 2 ist freilich die Basis- bzw. Serverinstallation, die als dritte Option bei der Paketauswahl angeboten wird. Die aktuelle Version von openSUSE ist deshalb die erste Freigabe von Leap, die ein explizites Serverprofil ohne eine grafische Oberfläche anbietet. Die Standardinstallation umfasst dabei lediglich das Basissystem. Weitere Dreingaben müssen manuell aus der Paketauswahl herausgesucht werden. Die Konfiguration der Server, aber auch des kompletten Systems übernimmt wie immer das Konfigurationswerkzeug Yast, das mittlerweile über schier unerschöpfliche Funktionen und Konfigurationsmöglichkeiten verfügt. Egal, ob es um die Installation von Software geht, die Einrichtung von Hardware oder die Benutzerverwaltung, an Yast führt in der Regel kein Weg vorbei. Das Universalwerkzeug ist auch unter openSUSE Leap 42.2 in verschiedenen Ausgaben verfügbar. Während unter KDE eine Qt-Version gestartet wird, führt der Distributor bei GNOME eine GTK+-Variante und in der Konsole bzw. Serverinstallation eine minimalistische Version aus.

Yast: Softwareauswahl in der Konsole.

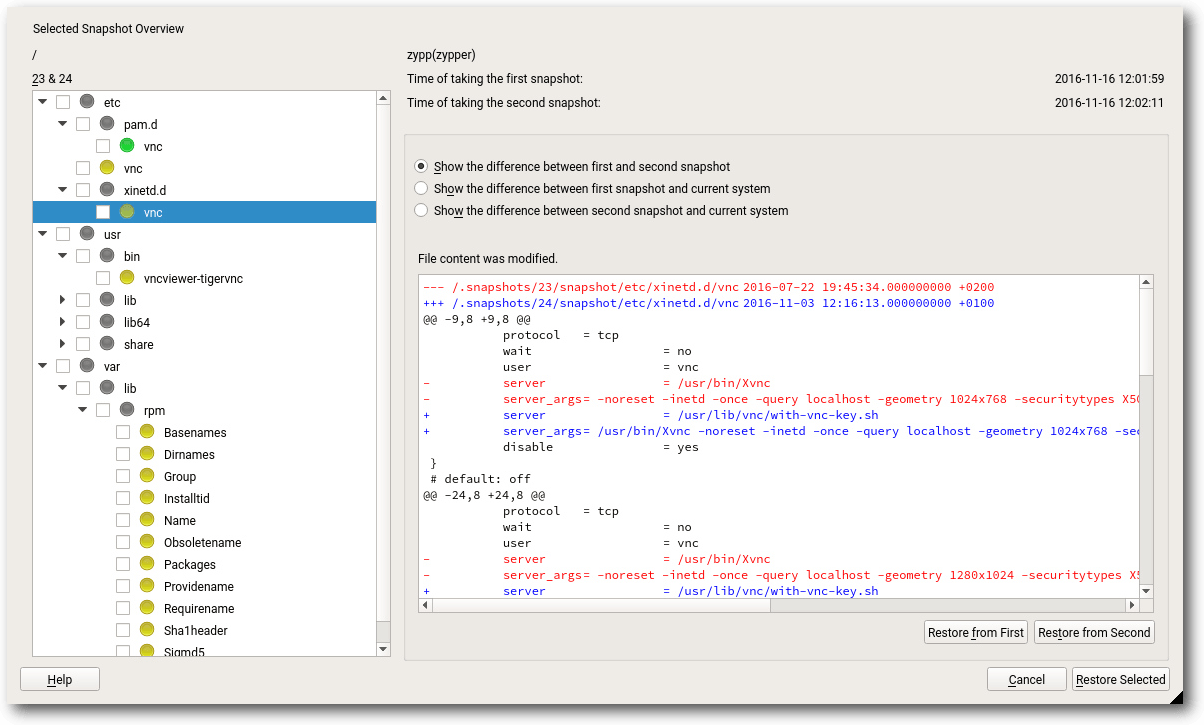

Das Werkzeug wurde gegenüber der letzten Version weiter ausgebaut und trägt nun die Versionsnummer 3.1.206. Eine der Neuerungen stellt die Implementierung von „yast2-alternatives“ dar – eines neuen Moduls, um das Alternatives-System von openSUSE zu regeln. Ein weiteres neues Modul ist „yast2-vpnb, das zu Konfiguration und von VPN-Gateways und Clients genutzt werden kann. „yast2-auth-client“ ist ein weiteres Modul, das in openSUSE Leap 42.2 neu hinzugefügt wurde. Die Lösung wurde entwickelt, um eine zentrale System-Authentifizierung zu konfigurieren. Neu in Yast sind zudem Verbesserungen des Bootloader-Managements und eine verbesserte Konfiguration des Passwortschutzes und der Sicherheit. „yast2-firewall“ beinhaltet jetzt beispielsweise eine komplette Unterstützung für firewalld, zusätzlich zur schon existierenden SuSEFirewall2. Wie sich für eine Distribution gehört, die ein Anspruch auf eine vollwertige Serverinstallation hat, liefert auch openSUSE eine Vielzahl an Servern und Diensten aus. Die meisten Anwendungen sind dabei bereits vorkonfiguriert und können prinzipiell ohne eine nachträgliche Konfiguration wenigstens gestartet werden. Besonders erfreulich für passionierte Heimnutzer und angehende Administratoren dürften wieder die vielen Helfer in YaST sein. So hat der Hersteller im Lieferumfang des Paketes YaST-Module für fast alle Server. Während manche Module nur marginale Einstellungen ermöglichen, erlauben andere wiederum eine fast vollständige Konfiguration.

Yast: Snapshotmanagement mittels Snapper.

Fazit